机构名称:

¥ 1.0

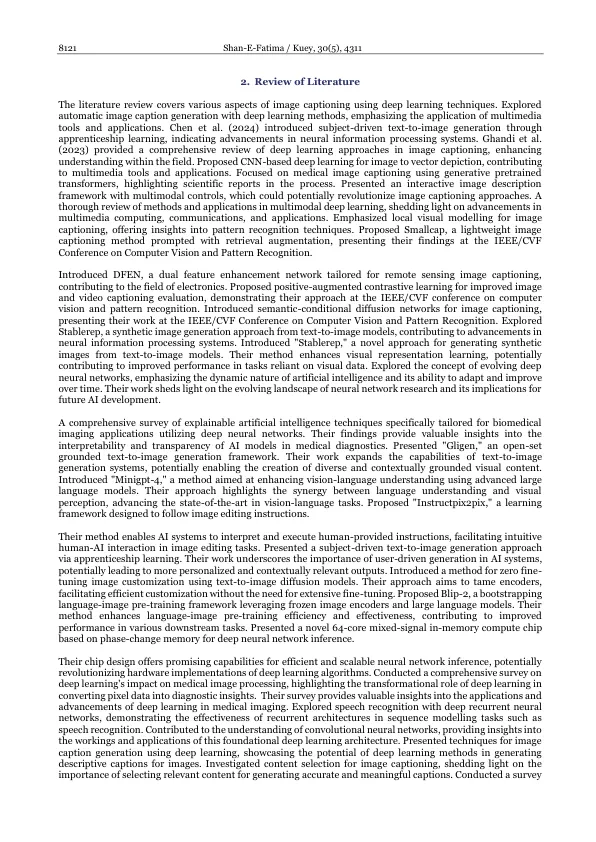

文章信息abs tract本研究研究了使用VGG16和LSTM架构在FlickR8K数据集上使用图像字幕模型的有效性。通过细致的实验和评估,获得了对模型能力的有价值的见解,并获得了为图像生成描述性字幕的局限性。这些发现有助于对图像字幕技术的更广泛理解,并为该领域的未来进步提供指导。VGG16和LSTM架构的探索涉及数据预处理,模型培训和评估。FlickR8K数据集,包括8,000张与文本描述配对的图像,作为基础。进行了数据预处理,使用VGG16的特征提取和LSTM训练。进行了模型参数和超参数的优化,以实现最佳性能。评估指标(包括BLEU得分,语义相似性评分和胭脂分数)。虽然根据BLEU评分观察到带有参考标题的中等重叠,但该模型表现出高度的语义相似性。然而,通过分析胭脂分数,揭示了维持连贯性和捕获高阶语言结构的挑战。这项研究的含义扩展到诸如计算机视觉,自然语言处理和人类计算机互动之类的领域。通过弥合视觉内容和文本描述之间的语义差距,图像字幕模型可以增强可访问性,改善图像理解并促进人类机器通信。尽管有希望捕获语义内容的表现,但存在改进的机会,包括精炼模型体系结构,集成注意力机制以及利用较大的数据集。图像字幕中的持续创新承诺在行业和学科中广泛应用的高级系统。关键字:图像字幕,深度学习,VGG16,LSTM,FlickR8K数据集,评估指标,语义差距,人类计算机交互。

AI自动驾驶:机遇,挑战和...韩国戏剧对心理井的影响使用深度学习算法的图像字幕生成

主要关键词