机构名称:

¥ 1.0

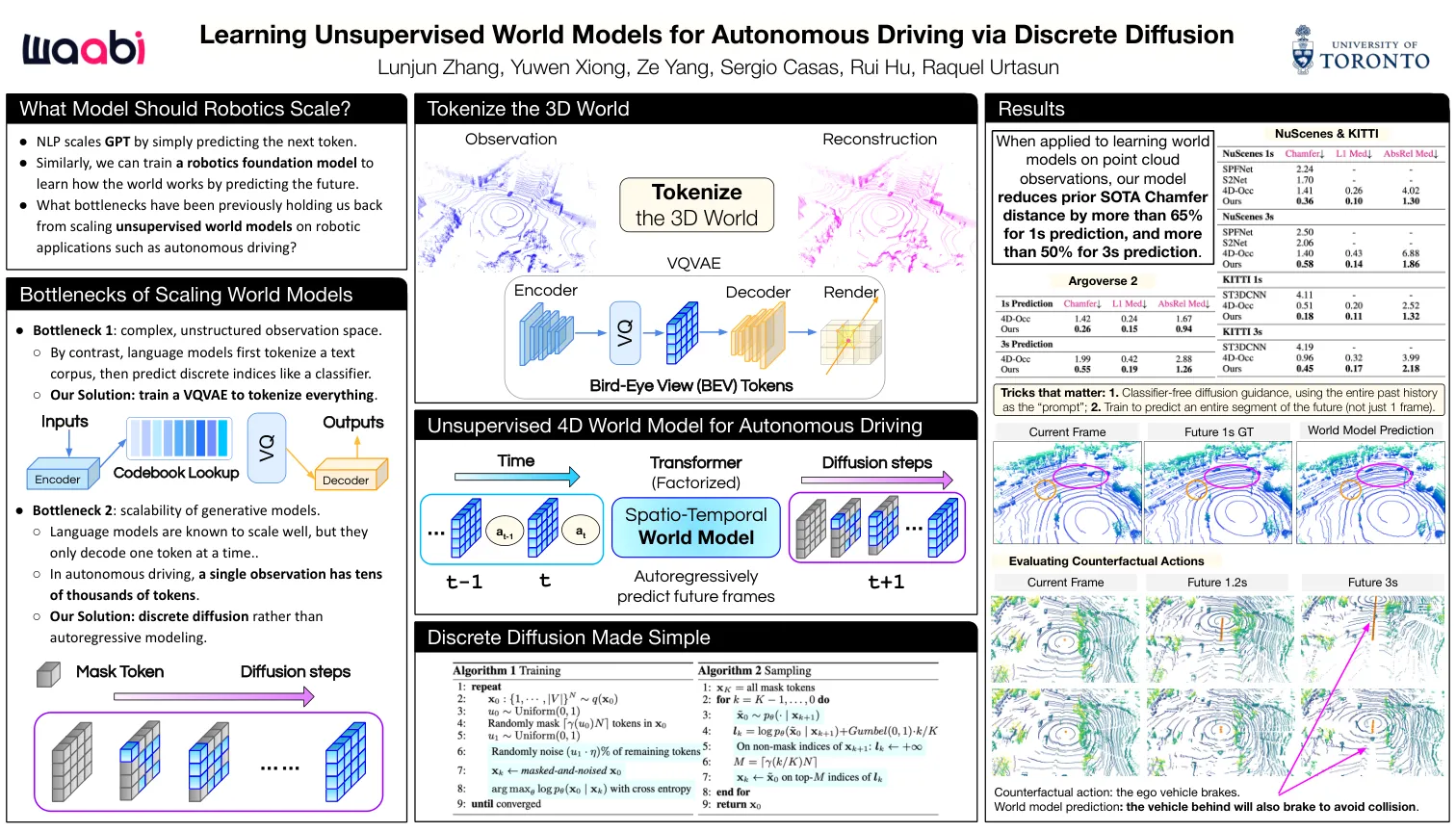

我们从专家演示中解决了政策学习的问题,而无需奖励。在这个领域的一个核心挑战是,由于分配转移,环境随机性或复杂错误的问题,这些政策在部署后失败。对抗性模仿学习可以减轻此问题,但需要额外的固定培训样本以进行稳定,这由于学习效率低下和较高的样本复杂性而在现实领域提出了挑战。解决这个问题的一种方法是学习环境的世界模型,并使用综合数据进行政策培训。尽管在先前的工作中取得了成功,但我们认为这是由于学习模型和真实环境之间的其他分布变化而是最佳的。相反,我们将模仿学习作为一个微调问题,而不是纯粹的加固学习。将理论连接到离线RL和微调算法,我们认为标准的在线世界模型算法不太适合模仿学习问题。我们得出了一种原则上的保守优化,并从经验上证明了它从高维原始像素观测值中的两个非常有挑战性的操纵环境中提高了性能。我们从图像中设置了弗兰加厨房环境上的最新性能,在没有奖励标签上只需要10个演示,并解决了复杂的敏捷性ma-nipulation任务。关键字:模仿学习,基于模型的学习,世界模型,微调

与保守世界模型有效的模仿学习

主要关键词