机构名称:

¥ 1.0

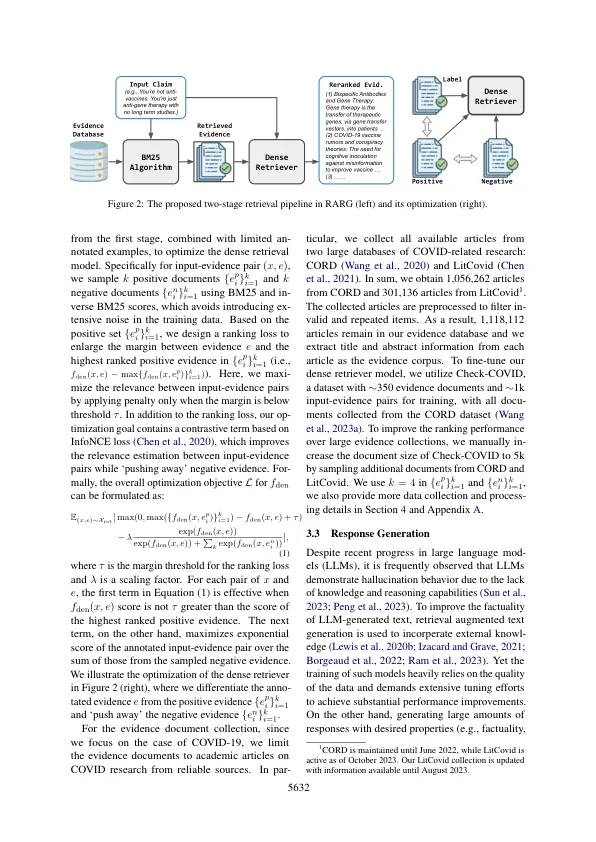

在线错误信息的扩散对公众造成了重大威胁。虽然许多在线用户积极参与反对错误信息的战斗,但由于缺乏礼貌和支持事实,许多这样的回应都可以使人具有特色。作为解决方案,提出了文本生成方法,以自动产生反误导响应。尽管如此,存在的方法通常是端对端训练的,没有利用外部知识,从而产生了低等的文本质量和过度重复的重音。在本文中,我们提出了在线误导(RARG)的检索响应产生,该响应产生从科学来源收集支持证据,并根据证据产生反弥散性响应。尤其是我们的RARG由两个阶段组成:(1)收集证据,我们在其中设计了一个检索管道来检索和重读证据文件,该数据库使用数据库包含100万个学术文章; (2)响应产生,其中我们调整大型语言模型(LLM),以通过从人类反馈(RLHF)学习来生成基于证据的重音。我们提出了一种奖励功能,以最大程度地利用检索到的证据,同时保持生成的文本的质量,从而产生礼貌和事实的回应,这些反应明显驳斥了错误的信息。为了证明我们方法的有效性,我们研究了Covid-19的案例,并对内部和跨域数据集进行了广泛的实验,在该数据集中,RARG始终通过产生高质量的反透明信息响应来表现基准。

循证驱动的检索增强响应生成用于在线错误信息

主要关键词