机构名称:

¥ 1.0

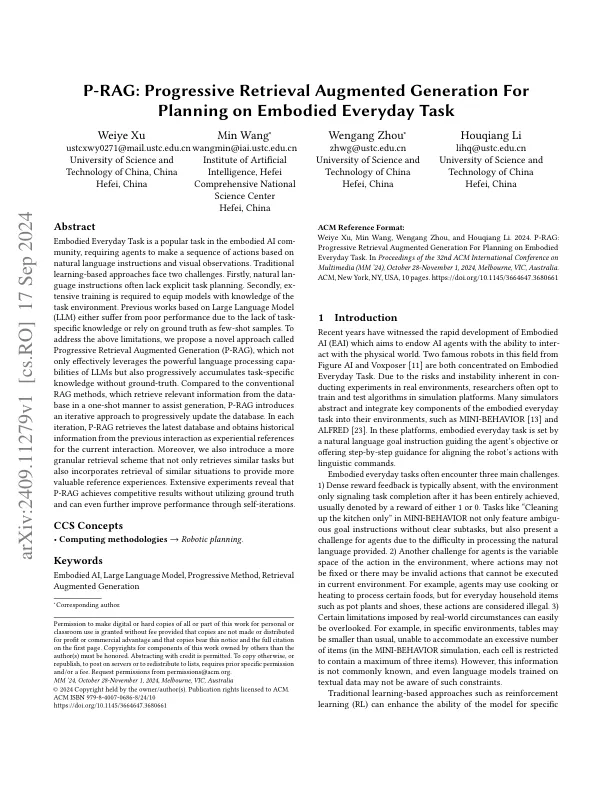

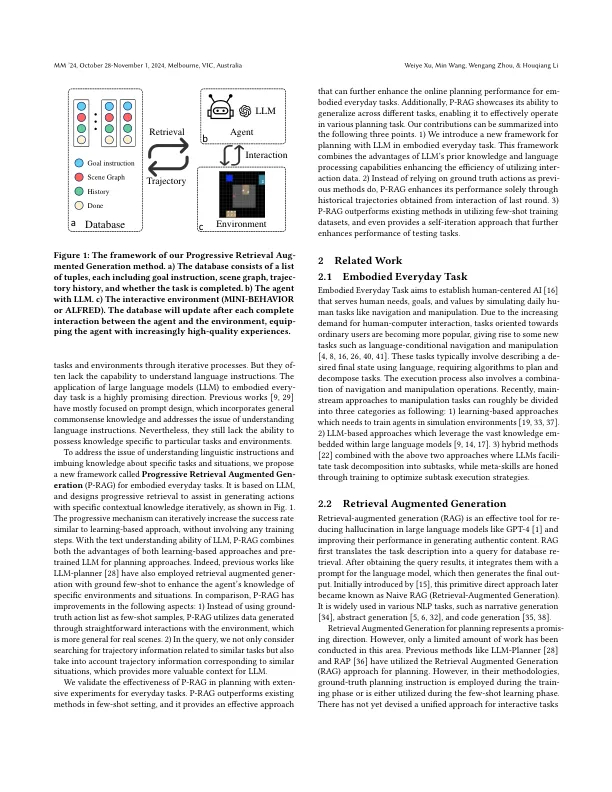

体现的日常任务是体现的AI社区中的一项流行任务,要求代理商根据自然语言说明和视觉观察做出一系列动作。传统的基于学习的方法面临两个挑战。首先,自然语言指令通常缺乏明确的任务计划。其次,需要进行高度培训才能为模型提供对任务环境的了解。以前基于大语言模型(LLM)的作品要么由于缺乏任务特定知识而遭受性能差,要么依靠地面真理作为少数样本。为了解决上述局限性,我们提出了一种称为渐进检索增强发电(P-rag)的新颖方法,该方法不仅有效地利用了LLMS的强大语言处理能力,而且还逐渐积累了特定于任务的知识而没有地面真相。与传统的抹布方法相比,该方法以单发方式从数据基础中检索相关信息以协助生成,p-rag引入了一种迭代方法来逐步更新数据库。在每次迭代中,p-rag检索最新数据库,并从上一个相互作用中获取历史信息,作为当前交互的经验参考。此外,我们还引入了一个更精细的检索计划,该计划不仅可以检索相似的任务,而且还结合了类似情况的检索,以提供更有价值的参考经验。广泛的实验表明,P-rag在不利用地面真理的情况下取得了竞争成果,甚至可以通过自我读取进一步提高绩效。

p-rag:逐步检索增强产生,用于计划体现的日常任务

主要关键词