机构名称:

¥ 2.0

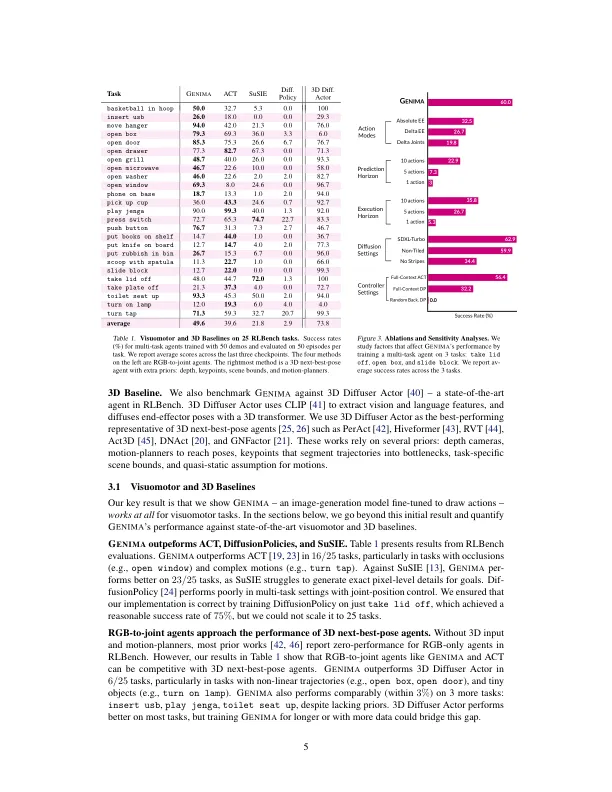

摘要:图像生成扩散模型已经过微调,以解锁新功能,例如图像编辑和新型视图合成。我们可以类似地解锁视力控制的图像生成模型吗?我们提出了G Enima,这是一种行为粘合剂,将稳定扩散到“绘制关节运动”作为RGB图像的目标。这些图像被馈入一个控制器,将视觉目标映射到一系列关节位。我们在25个rlbench和9个现实的操纵任务上研究G尼马。我们发现,通过将动作提升到图像空间中,Internet预训练的扩散模型可以生成优于状态的视觉运动方法的策略,尤其是在对场景扰动的鲁棒性和对新颖对象的推广方面。尽管缺乏深度,关键点或运动规划剂等先验,我们的方法也与3D代理具有竞争力。

生成图像作为动作模型