机构名称:

¥ 3.0

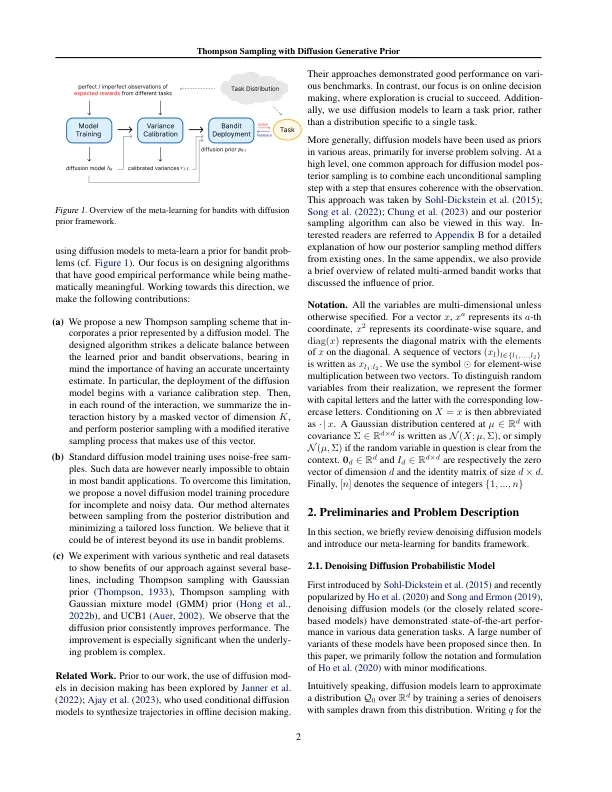

在这项工作中,我们启动了使用Denois扩散模型来学习在线决策问题的先验的想法。我们专门针对强盗元学习,旨在学习一项跨同一班级的强盗任务的策略。为此,我们训练一个扩散模型,该模型在测试时处理了基本的任务分布,并在处理新任务之前与学习的汤普森采样。我们的后抽样算法仔细平衡了学识渊博的先验和嘈杂的观察结果,这些观察结果来自学习者与环境的相互作用。为了捕获现实的强盗情景,我们提出了一种新型的扩散模型训练程序,该过程从不完整和嘈杂的数据中训练,这可能具有独立的兴趣。最后,我们的广泛实验清楚地证明了所提出的方法的潜力。

用扩散生成的汤普森采样