机构名称:

¥ 1.0

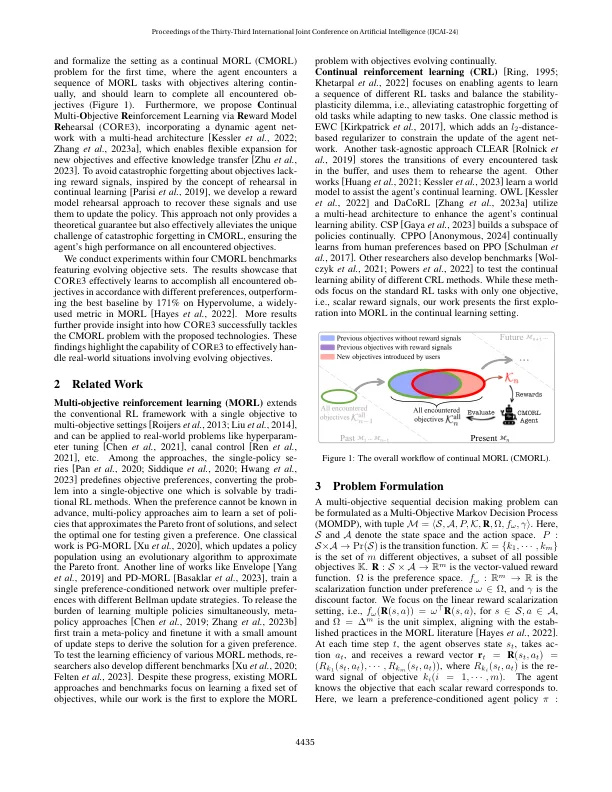

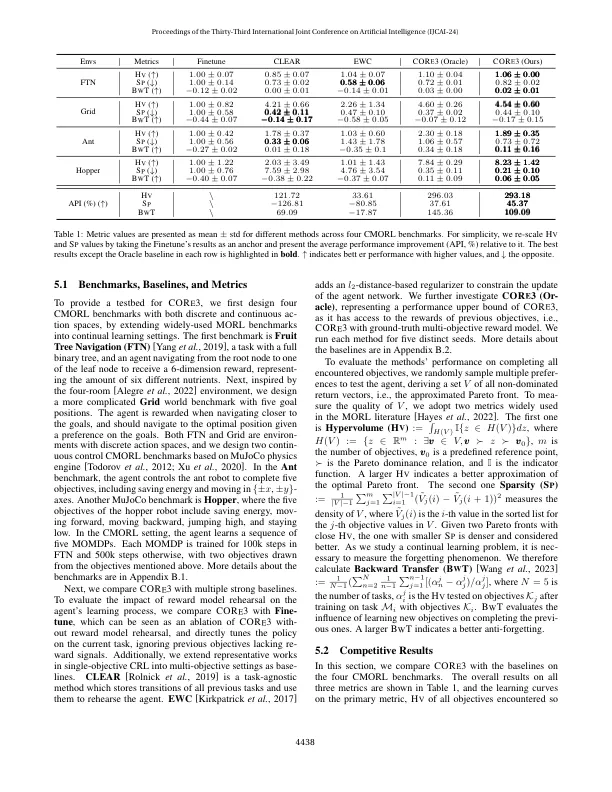

多目标加固学习(MORL)方法通过学习最大化的政策来解决现实世界中的问题,以不同的用户偏好加权。典型方法假定目标在整个代理人的寿命中都没有变化。,在某些现实情况下,代理商可能会遇到动态改变学习的方法,即在不同的学习阶段,不同的矢量值奖励功能。在概率公式或算法设计中尚未考虑这个发展目标的问题。为了解决这个问题,我们首次将设置作为连续的MORL(CMORL)问题,这是为了通过学习过程的目标发展。随后,我们提出了通过Re Ward Model Re re Hearsal(Cor E 3)学习的c ontinual多O型信息,从而使动态代理网络不合转,以快速适应新目标。此外,我们开发了一种奖励模型彩排技术,以恢复以前目标的重新信号,从而减轻灾难性的遗忘。在四个CMORL基准测试基准上进行的实验展示了Cor E 3有效地学习满足所有遇到的目标的不同偏好的政策,并以171%的态度表现出最佳的基线,突显了Cor E 3的能力,可以处理具有渐进目标的情况。

通过奖励模型彩排持续的多目标增强学习

主要关键词