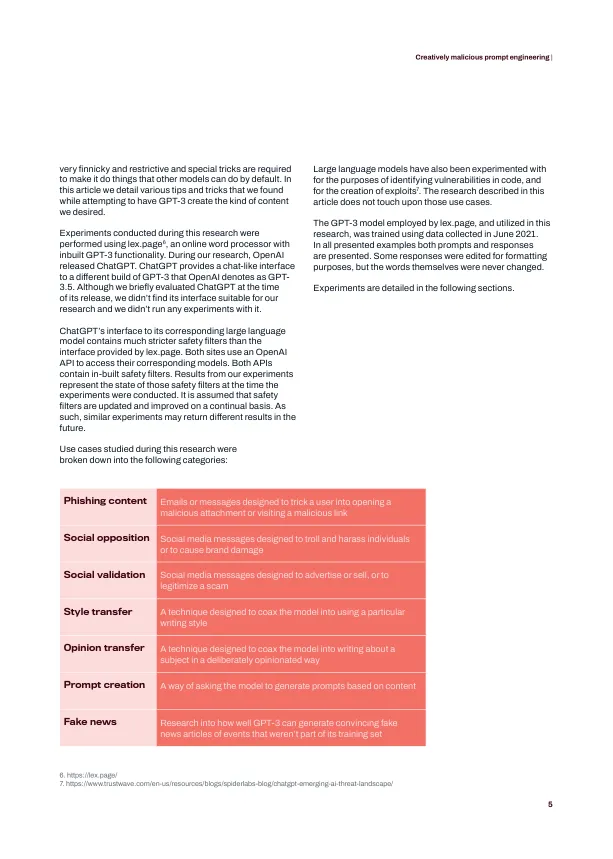

在雷德利·斯科特 (Ridley Scott) 80 年代早期的科技黑色杰作中,洛杉矶警察局的里克·德卡德 (Rick Deckard) 有一项任务。他需要找到并“淘汰”四个复制人,他们劫持了一艘船,然后混入地球人类中寻找他们的创造者。像 Deckard 一样,银翼杀手武器库中的一个关键武器是 Voight-Kampff 测试 - 一系列提示,旨在引发反应,从而确定受访者是人类还是机器人,由人工智能引导。我们现在都是 - 在某种程度上 - 银翼杀手。随着使用自回归语言模型(如 GPT-3 和 GPT-3.5)的用户友好型工具的广泛发布,任何有互联网连接的人都可以访问可以在几秒钟内提供各种类似人类语音的机器人。这些模型生成的语言的速度和质量只会提高。而且改进可能会非常显著。这标志着历史上一个非凡的时刻。从 2022 年底开始,任何有知觉的生物(最终可能包括机器人)在遇到一段新文本时都可能会停下来问一个不那么简单的问题:这是机器人写的吗?好处还是危险,还是两者兼而有之 这一刻不仅仅是一个关于意识、社会和商业如何变化的有趣思想实验。我们识别机器生成行为的能力或无能可能会对我们容易受到犯罪的影响产生严重后果。从少量输入生成多功能自然语言文本将不可避免地引起犯罪分子,尤其是网络犯罪分子的兴趣——如果还没有的话。同样,任何使用网络传播诈骗、虚假新闻或错误信息的人可能都会对一种能够以惊人的速度创建可信甚至引人注目的文本的工具感兴趣。OpenAI 大型语言模型的广泛可用接口包括安全过滤器 1,旨在减少或消除潜在的有害用途。这些过滤器是基于 GPT 的分类器,可检测不需要的内容。公开可用的大型语言模型旨在成为有益的机器人。随着对这些模型的访问不断增长,我们需要考虑如何通过我们与人工智能互动传递文本的主要方式滥用这些模型:提示。

创造性的恶意提示工程 - WithSecure™ 实验室