机构名称:

¥ 1.0

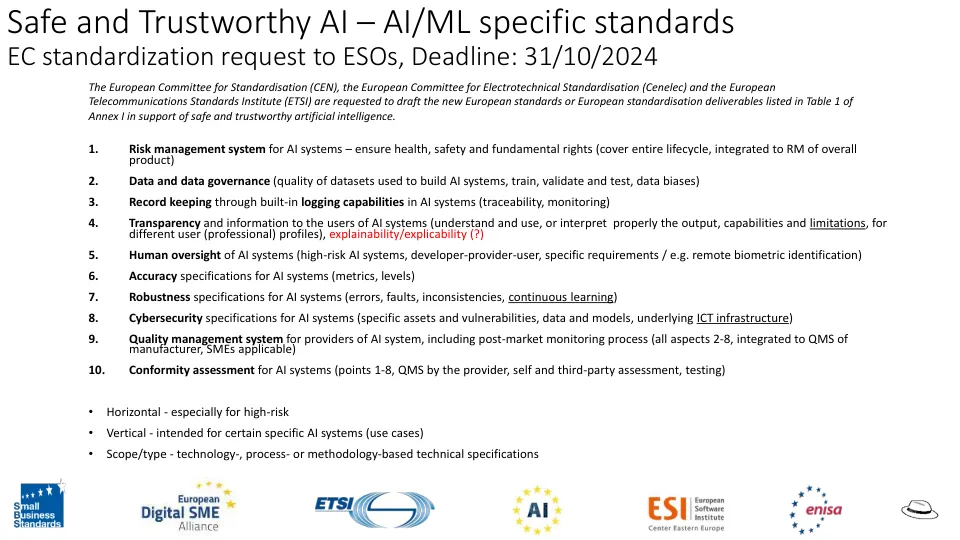

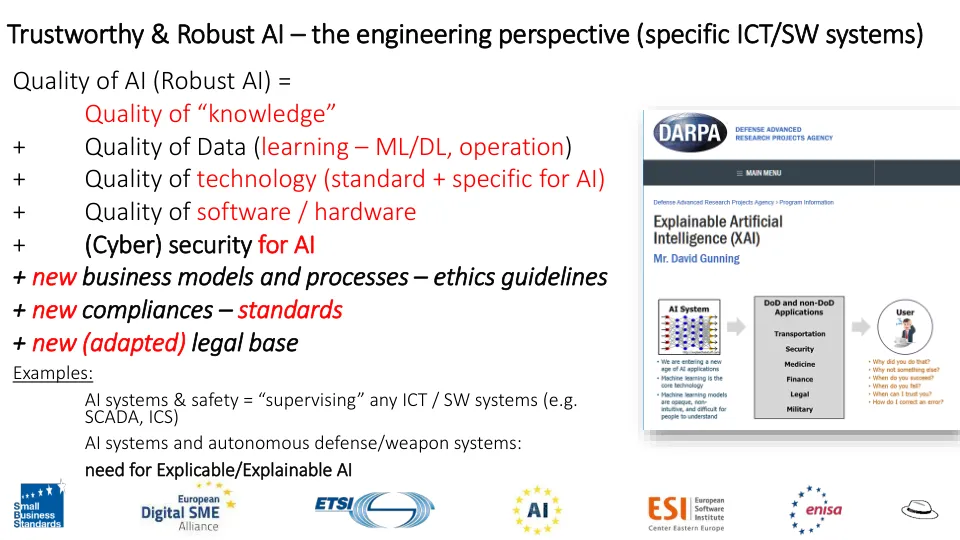

序言 48-51:高风险人工智能系统应“具有抵御与系统限制相关的风险(例如错误、故障、不一致、意外情况)以及可能危及人工智能系统安全的恶意行为的能力……”ENISA 目前正在研究制定人工智能系统网络安全认证计划所涉及的主要考虑因素,预计本月将发布一份报告 (?)该法案的主要网络安全特定义务在第 15 条中列出,相应的透明度义务在第 13 条中列出。该法案要求高风险人工智能系统具有适当的稳健性、准确性和网络安全水平,并且必须在整个生命周期内保持这些水平。要采用的具体技术解决方案将取决于具体情况和风险。这些要求与现有立法重叠,即法规 2019/881 (CSA) 中规定的认证流程。

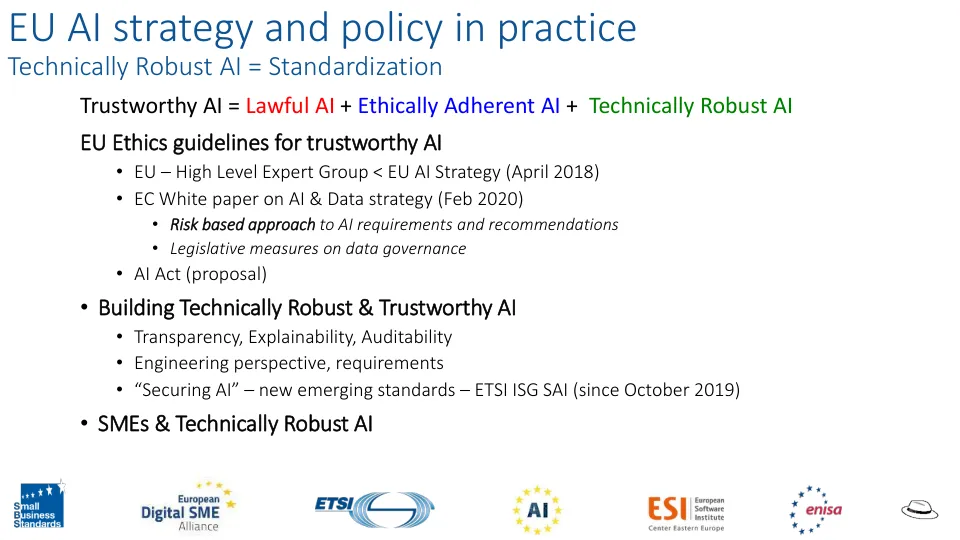

可信人工智能的欧洲标准化格局 & ...