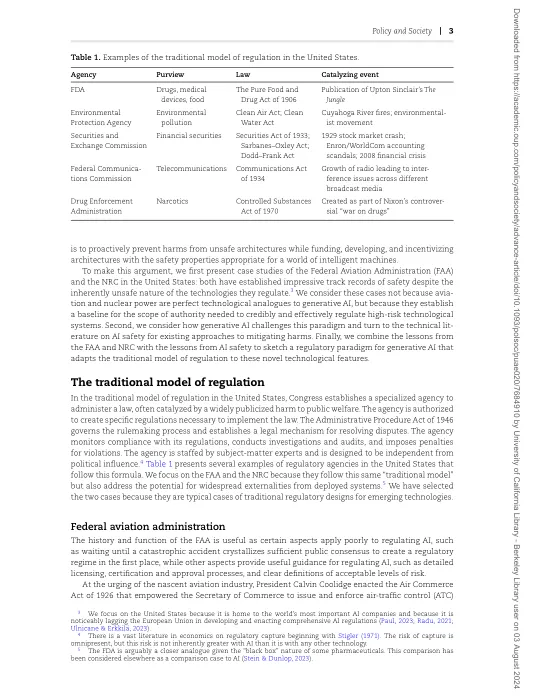

机构名称:

¥ 1.0

本文探讨了监管人工智能 (AI) 系统所面临的挑战,并提出了一种适合 AI 新功能的监管模式。与过去的技术不同,使用深度学习等技术构建的 AI 系统无法直接分析、指定或根据法规进行审计。它们的行为是不可预测的,源自训练而非有意设计。然而,将监督委托给专家机构的传统模式不应完全抛弃,这种模式在航空和核电等高风险领域取得了成功。相反,政策制定者必须控制当今不透明模型带来的风险,同时支持对可证明安全的 AI 架构的研究。借鉴 AI 安全文献和过去监管成功的经验,有效的 AI 治理可能需要整合权力、许可制度、强制训练数据和建模披露、系统行为的正式验证以及快速干预的能力。

重新思考人工智能的监管 - EECS 人员