机构名称:

¥ 5.0

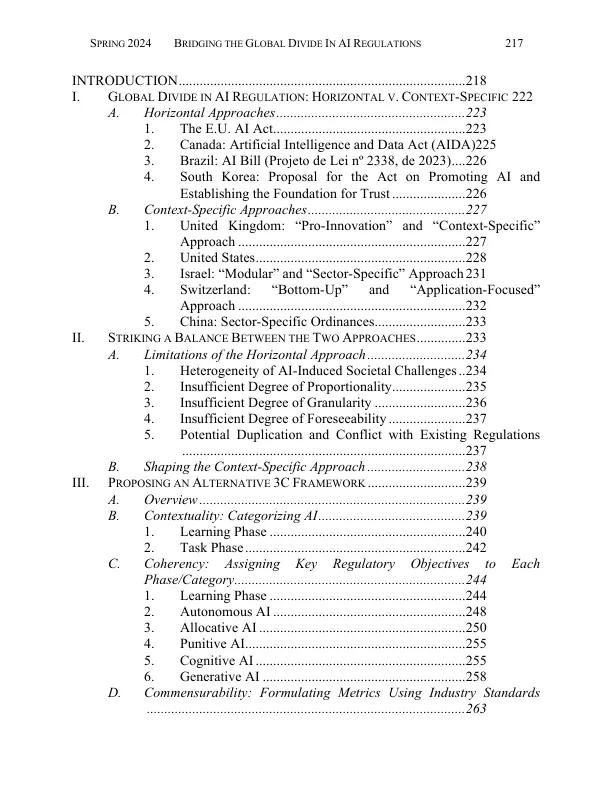

摘要 :随着有关人工智能 (AI) 潜在社会危害的争论在立法和国际规范中达到高潮,全球在人工智能监管框架和国际治理结构方面都出现了分歧。在地方监管框架方面,欧盟 (EU)、加拿大和巴西遵循“横向”或“横向”方法,假定人工智能的同质性,寻求找出共同的危害原因,并要求统一的人为干预。相比之下,美国 (US)、英国 (UK)、以色列和瑞士(可能还有中国)则采取了“针对特定情况”或“模块化”方法,根据人工智能系统的具体用例制定法规。在国际治理结构方面,联合国正在探索一个集中的人工智能治理框架,由一个与国际原子能机构相当的高级机构进行监督。然而,英国正在率先采用去中心化治理模式,美国和其他几个国家也已认可这种模式,即每个司法管辖区的人工智能安全机构根据可互操作的标准对高性能通用模型的安全性进行评估。本文主张在去中心化治理的同时采取针对具体情况的方法,以有效应对不同关键任务领域不断演变的风险,同时避免一刀切方法带来的社会成本。然而,为了增强国际规范的系统性和互操作性并加速全球协调,本文提出了一个替代性的、针对具体情况的、连贯的和可比的 (3C) 框架。为了确保针对具体情况,该框架 (i) 将人工智能生命周期分为两个阶段:针对特定任务的学习和部署,而不是定义基础或通用模型;(ii) 根据这些任务的应用和与人类的交互将它们分为自主型、判别型(分配型、惩罚型和认知型)和生成型人工智能。为了确保一致性,每个类别都被赋予了具体的监管目标,以取代 2010 年代过时的“人工智能伦理”。为了确保可比性,该框架提倡采用国际标准来衡量和减轻风险。

弥合人工智能监管的全球鸿沟

主要关键词