机构名称:

¥ 1.0

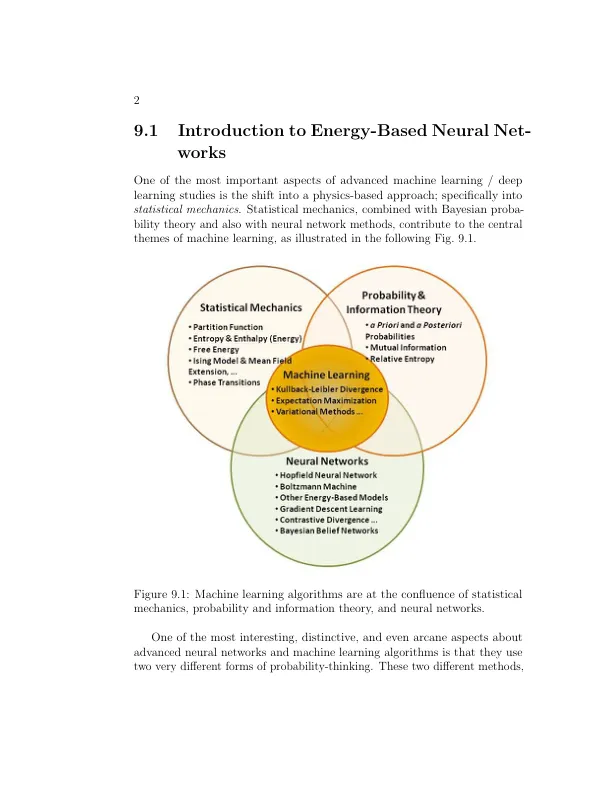

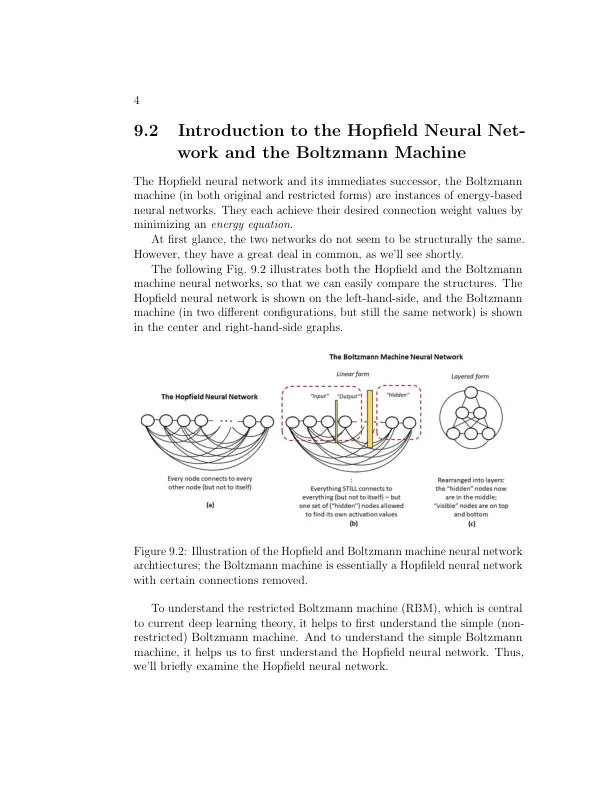

分别来自统计力学和贝叶斯概率的方法对于思考某事是否发生的可能性来说是截然不同的。统计力学是理论物理学的一个领域,在神经网络中主要用作寓言;作为在一个领域创建的模型,并(非常有用地)应用于另一个领域。这几乎就像用物理学来讲故事。这些方法可以成功使用的想法是如此极端,以至于这些方法可以在神经网络和深度学习中找到新家几乎令人震惊。统计力学的概念是受限玻尔兹曼机 (RBM) 学习方法的核心。受限玻尔兹曼机使用的底层方法与随机梯度下降实现(例如反向传播)所使用的方法非常不同。这意味着 RBM 可以具有多层架构并学会区分更复杂的模式,从而克服我们之前讨论过的简单多层感知器 (MLP) 的局限性。统计力学处理的是只能通过其能量状态来区分的小单元的发生概率。相比之下,贝叶斯概率提供了一种截然不同的思考事情发生概率的方式。这两种面向概率的方法共同为高级机器学习方法奠定了基础。既然我们已经确定了统计力学和贝叶斯方法的重要性,我们将把注意力(针对本章和紧接着的章节)限制在统计力学及其与神经网络的基础关系上。稍后,当我们讨论更高级的主题时,我们将全面讨论统计力学和贝叶斯方法的融合。统计力学在神经网络中的作用首次为人所知是在 1982 年 John Hopfield 发表他的研究成果时 [1]。他的研究成果借鉴了 Little 及其同事在 1974 年 [2] 提出的观点。本章介绍了统计力学中的一些关键概念;足以理解一些经典论文的主题:Hopfield 的原创成果(介绍了后来被称为 Hopfield 网络的内容)以及由 Geoffery Hinton 及其同事开发的玻尔兹曼机的一些关键成果。

统计力学、神经网络和人工智能...

主要关键词