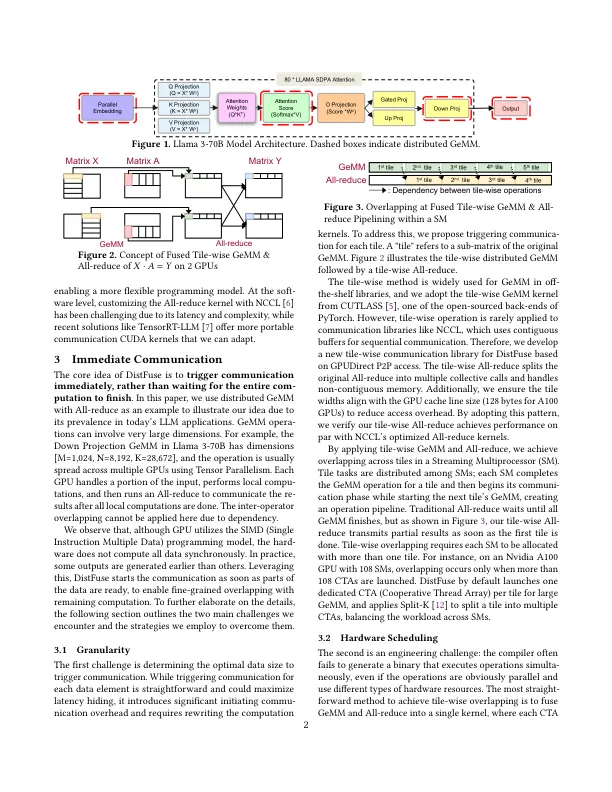

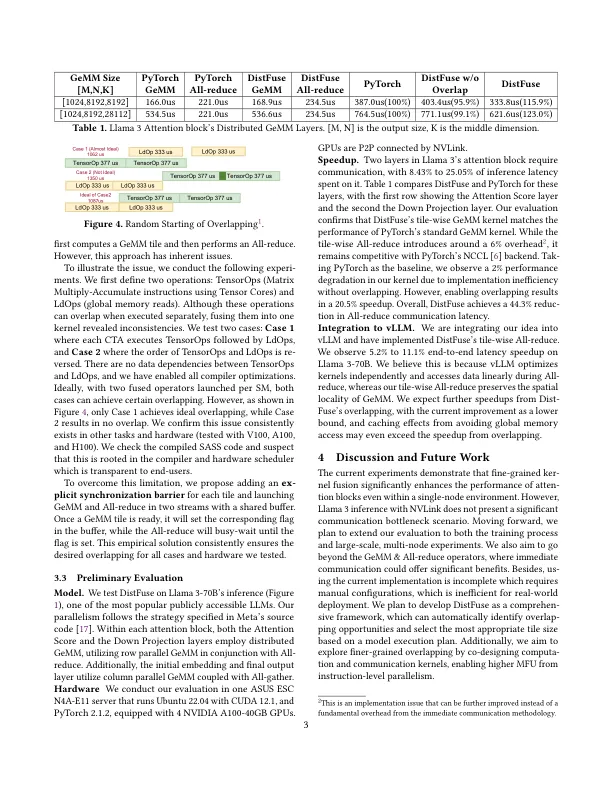

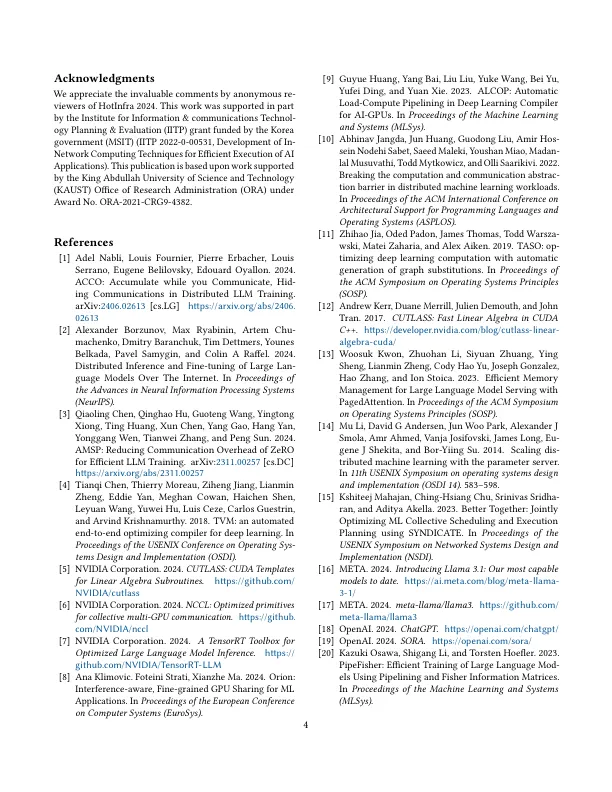

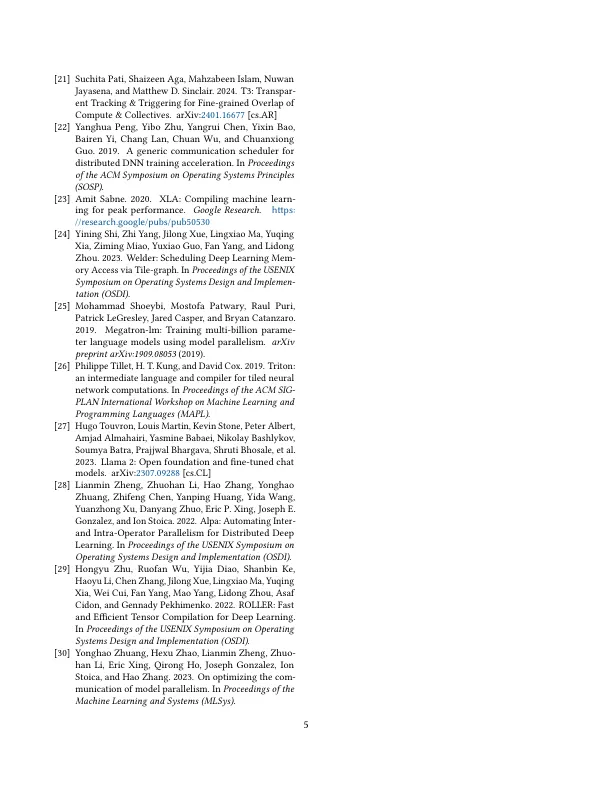

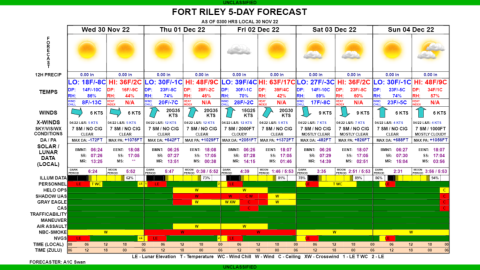

1 简介 人工智能领域的最新进展由 ChatGPT [ 18 ] 和 SORA [ 19 ] 等大型模型推动,带来了巨大的计算挑战。扩展这些模型通常需要多 GPU 或多节点系统 [ 2 , 14 ],利用张量并行等并行策略 [ 25 ] 来处理计算负载。例如,Llama 3.1-405B 模型训练使用了 16,000 个 H100 GPU [ 16 ]。然而,分布式计算引入了通信作为主要瓶颈,占执行时间的 80%,如 Llama 2-7B 模型所示 [ 1 ]。如 [ 3 ] 所示,将 Llama 2-13B [ 27 ] 训练从 8 个 GPU 扩展到 1,024 个 GPU 会因通信开销而将模型 FLOP 利用率 (MFU) 从 47% 大幅降低至 4%。这凸显了一个关键问题:尽管硬件功能有所进步,但由于引入了通信开销,硬件(尤其是 GPU)往往未得到充分利用。为了提高 MFU,先前的研究探索了通过通信 [ 20 、 22 、 28 、 30 ] 或数据加载 [ 9 ] 来提高硬件利用率的潜力。然而,这些策略主要侧重于重叠计算运算符和独立通信运算符。如果存在依赖关系(例如在推理阶段),则计算和通信都位于关键路径上,运算符间重叠是不可行的。认识到这一机会,我们引入了 DistFuse,这是一个即使在存在依赖关系的情况下也能促进细粒度重叠的系统。DistFuse 的核心旨在协调计算和通信,这样 GPU 就可以在部分数据准备就绪时立即启动通信,而不是等待整个数据。我们进行了一项概念验证实验,通过在单个节点上将 DistFuse 与 Llama 3-70B 的推理相结合来展示性能提升,该节点可以隐藏高达 44.3% 的通信延迟。我们目前的原型专注于 LLM 任务,但即时通信的核心概念是多功能的,可以应用于其他场景,例如卷积模型。鉴于数据中心中大型模型工作负载的日益普及以及对高效通信的需求不断增长,我们预计通过我们的技术将显着提高性能。此外,我们

分布式 AI 任务的即时通信

主要关键词