机构名称:

¥ 1.0

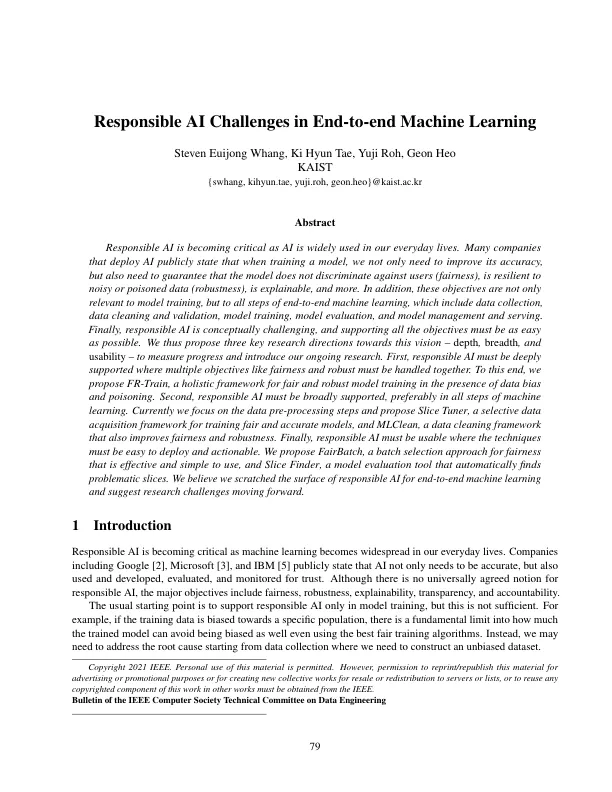

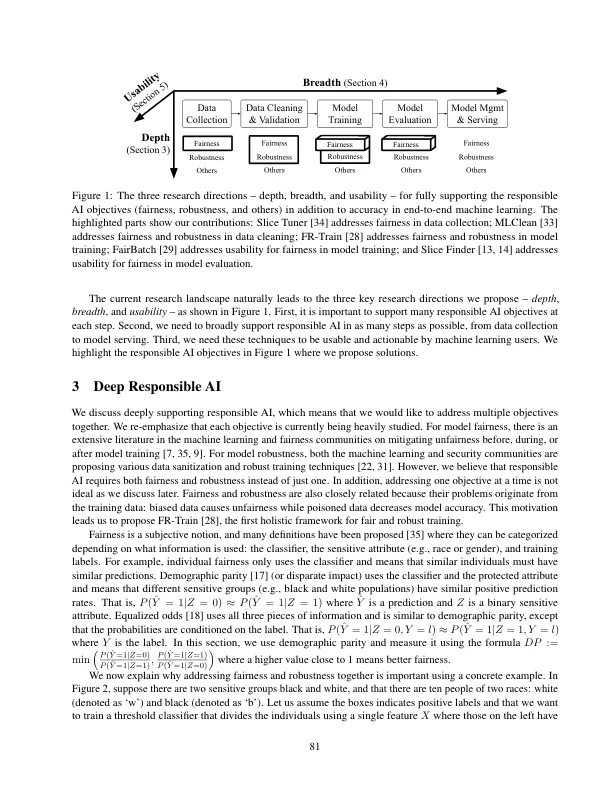

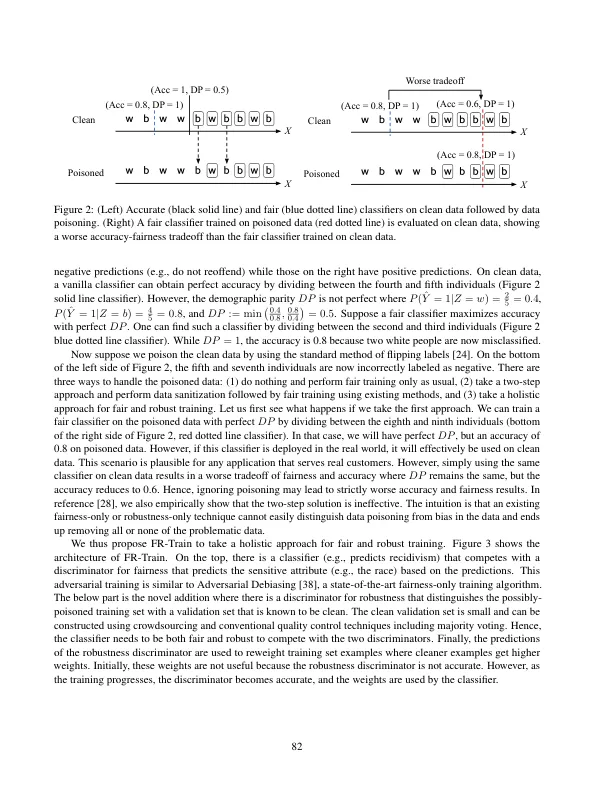

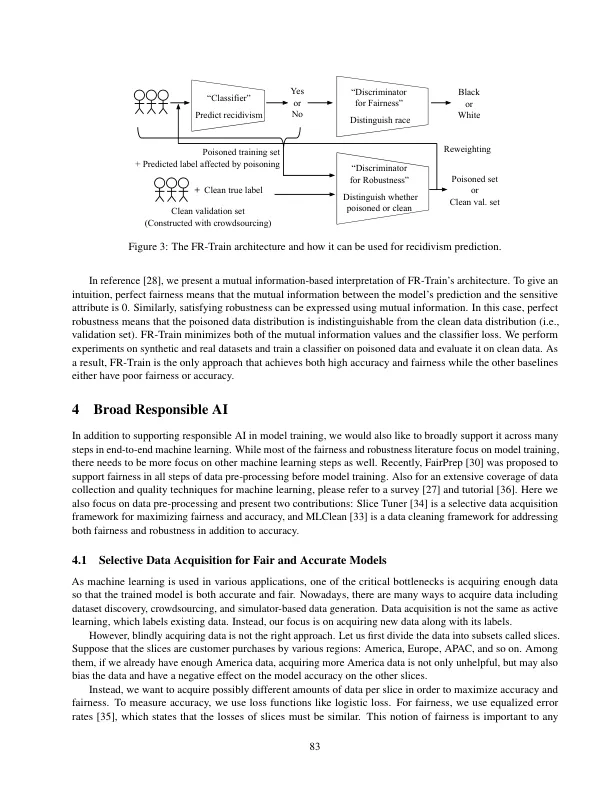

随着人工智能在我们日常生活中的广泛应用,负责任的人工智能变得越来越重要。许多部署人工智能的公司公开表示,在训练模型时,我们不仅需要提高其准确性,还需要保证模型不会歧视用户(公平性)、能够抵御嘈杂或中毒数据(鲁棒性)、可解释等等。此外,这些目标不仅与模型训练有关,而且与端到端机器学习的所有步骤有关,包括数据收集、数据清理和验证、模型训练、模型评估以及模型管理和服务。最后,负责任的人工智能在概念上具有挑战性,支持所有目标必须尽可能简单。因此,我们提出了实现这一愿景的三个关键研究方向——深度、广度和可用性——以衡量进展并介绍我们正在进行的研究。首先,必须深入支持负责任的人工智能,其中必须同时处理公平性和鲁棒性等多个目标。为此,我们提出了 FR-Train,这是一个在存在数据偏见和中毒的情况下进行公平和鲁棒模型训练的整体框架。其次,负责任的人工智能必须得到广泛支持,最好是在机器学习的所有步骤中。目前,我们专注于数据预处理步骤,并提出了 Slice Tuner(一种用于训练公平和准确模型的选择性数据采集框架)和 MLClean(一种也可以提高公平性和鲁棒性的数据清理框架)。最后,负责任的人工智能必须是可用的,其中技术必须易于部署和可操作。我们提出了 FairBatch(一种有效且易于使用的公平性批次选择方法)和 Slice Finder(一种自动查找有问题的切片的模型评估工具)。我们相信我们触及了端到端机器学习负责任人工智能的表面,并提出了未来的研究挑战。

端到端机器学习中负责任的人工智能挑战

主要关键词