机构名称:

¥ 2.0

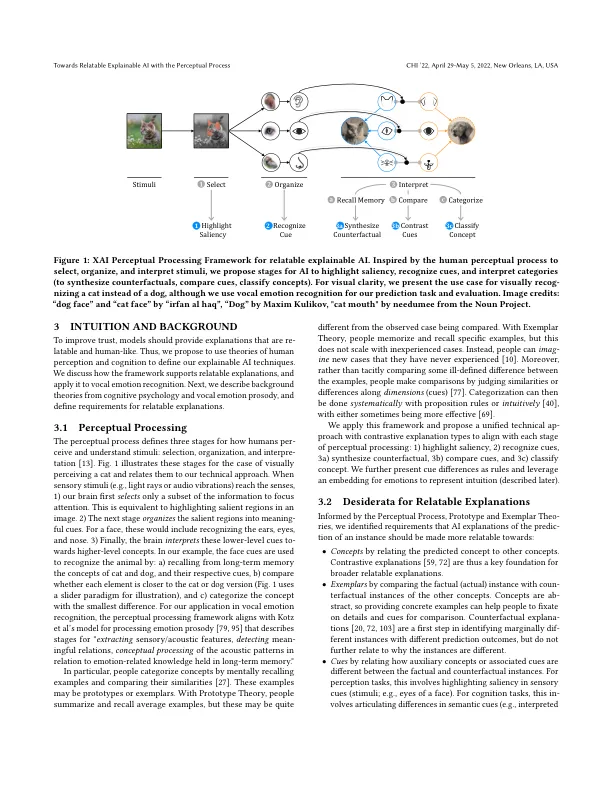

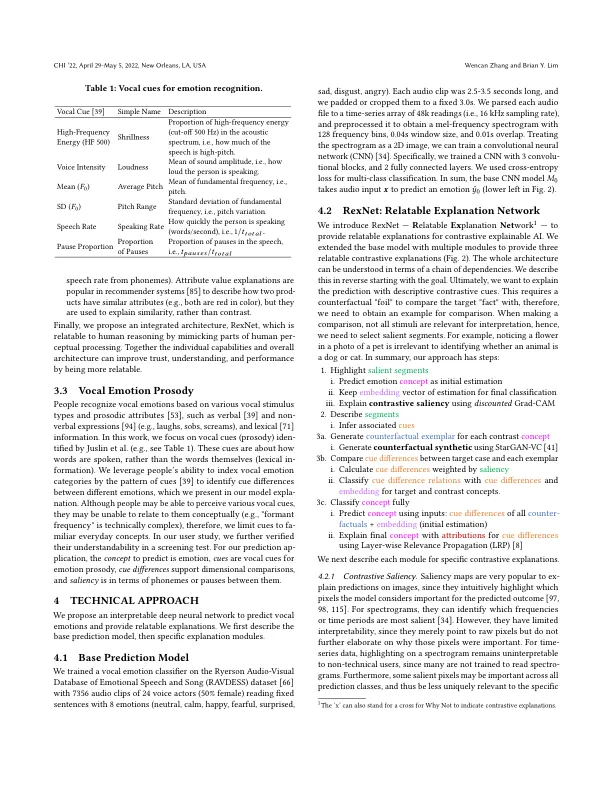

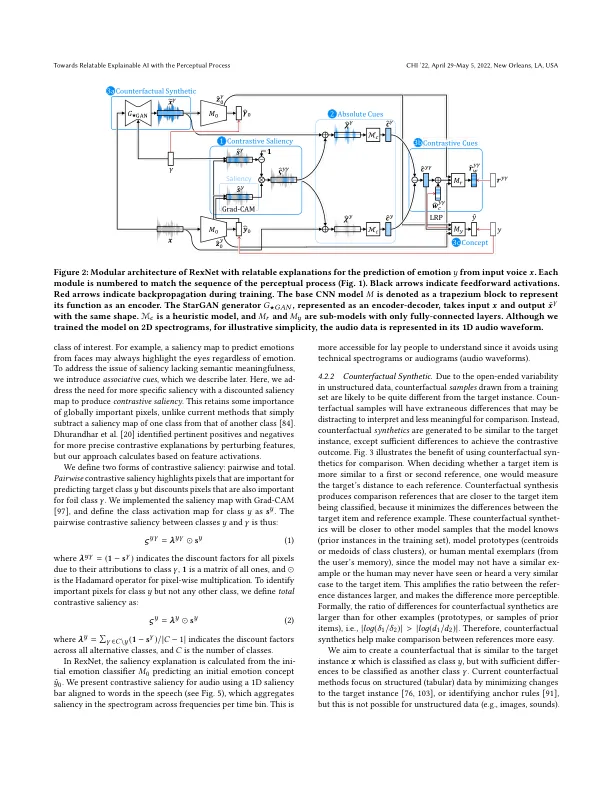

机器学习模型需要提供对比性解释,因为人们经常试图理解为什么会出现令人费解的预测而不是某些预期的结果。当前的对比性解释是示例或原始特征之间的基本比较,由于缺乏语义含义,因此仍然难以解释。我们认为解释必须与其他概念、假设和关联更相关。受认知心理学感知过程的启发,我们提出了 XAI 感知处理框架和 RexNet 模型,用于具有对比显着性、反事实合成和对比线索解释的可关联可解释 AI。我们研究了语音情绪识别的应用,并实现了一个模块化多任务深度神经网络来预测和解释语音中的情绪。从出声思考和受控研究中,我们发现反事实解释很有用,并且可以通过语义线索得到进一步增强,但不是显着性解释。这项工作为提供和评估用于感知应用的可关联对比可解释 AI 提供了见解。

通过感知过程实现可关联、可解释的人工智能