机构名称:

¥ 1.0

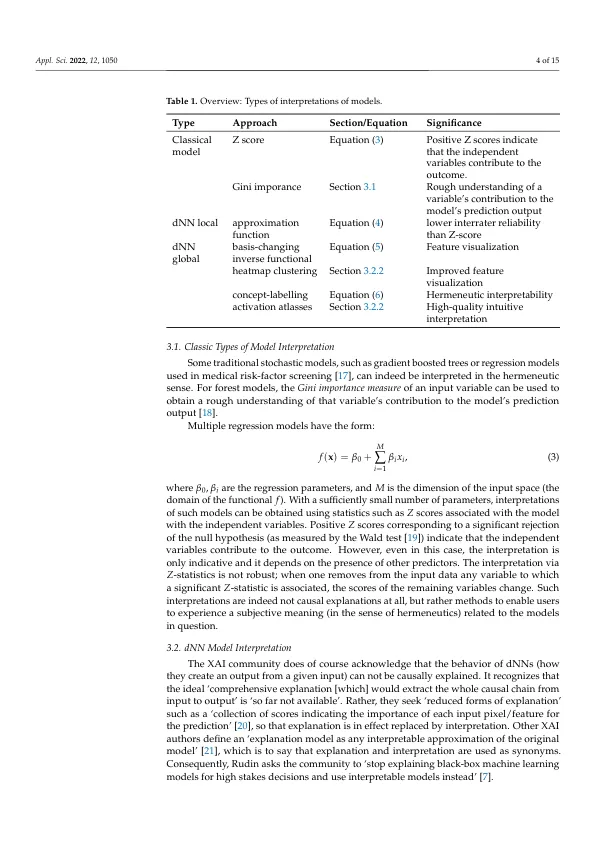

摘要:隐式随机模型,包括“深度神经网络”(dNN)和最近的无监督基础模型,是无法解释的。也就是说,无法确定它们的工作原理,因为它们方程中包含的数百万或数十亿个项之间的相互作用无法以因果模型的形式捕获。由于随机人工智能系统的用户希望了解它们的运行方式,以便能够安全可靠地使用它们,因此出现了一个名为“可解释人工智能”(XAI)的新领域。然而,当我们研究 XAI 文献时,很明显它的倡导者已经将“解释”一词重新定义为其他含义,即“解释”。解释有时确实是可能的,但我们表明,它们充其量只能提供对模型如何工作的主观理解。我们提出了一种可替代 XAI 的方法,即认证 AI (CAI),并描述了如何指定、实现和测试 AI 以获得认证。最终方法将本体论和形式逻辑与统计学习相结合,以获得可安全用于技术应用的可靠 AI 系统。

可认证的人工智能

主要关键词