机构名称:

¥ 2.0

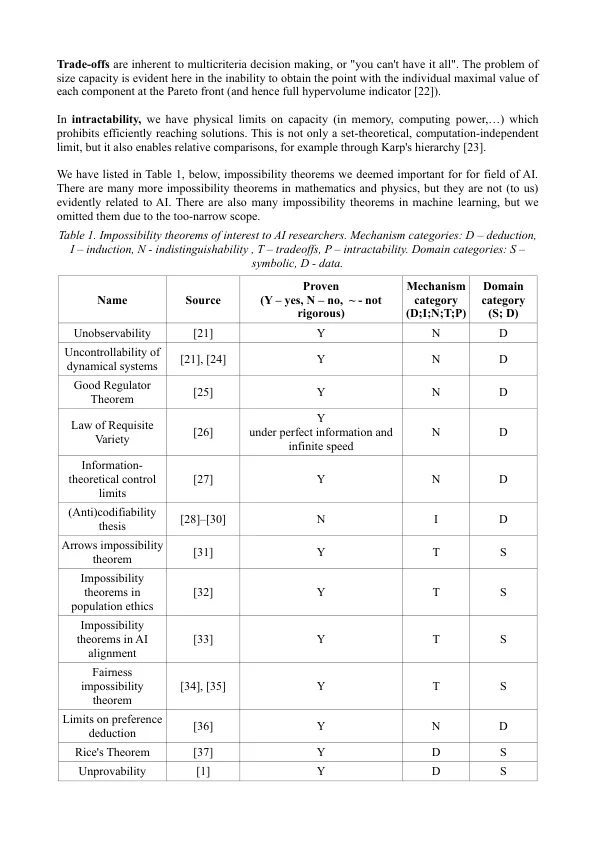

2 路易斯维尔大学 mario.brcic@fer.hr, roman.yampolskiy@louisville.edu 摘要 不可能定理表明,某个特定问题或一组问题无法按照声明中描述的方式解决。此类定理限制了人工智能(尤其是超级智能)所能做的事情。因此,这些结果可作为人工智能安全、人工智能政策和治理研究人员的指导方针、提醒和警告。这些可能以在约束满足框架内形式化理论的形式解决一些长期存在的问题,而无需承诺一种选择。我们坚信这是长期人工智能安全计划最谨慎的方法。在本文中,我们将适用于人工智能的不可能定理分为五种基于机制的类别:演绎、不可区分、归纳、权衡和难解性。我们发现某些定理过于具体或具有限制应用的隐含假设。此外,我们还添加了新的结果(定理),例如可解释性的不公平性,这是归纳类别中第一个与可解释性相关的结果。其余结果处理克隆之间的错位,并对代理的自我意识设置限制。我们得出结论,演绎不可能性否认了 100% 的安全保证。最后,我们给出了一些在可解释性、可控性、价值一致性、道德和群体决策方面具有潜力的想法。它们可以通过进一步调查来深化。

人工智能带来的不可能结果:一项调查

主要关键词