机构名称:

¥ 1.0

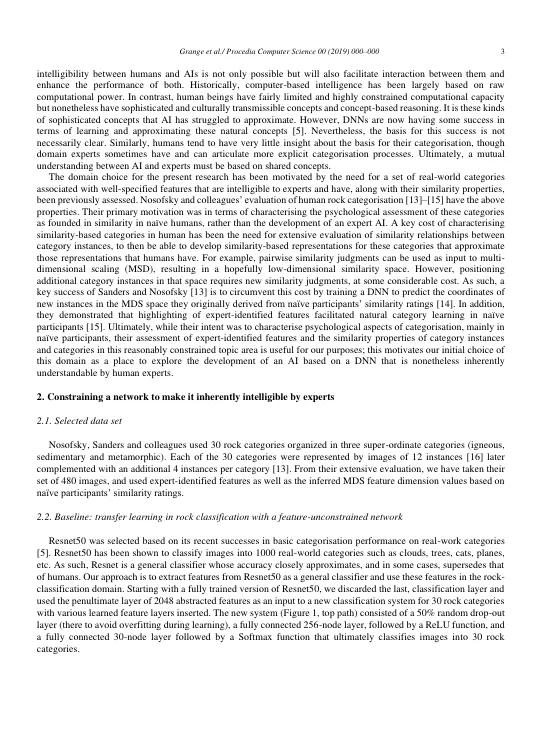

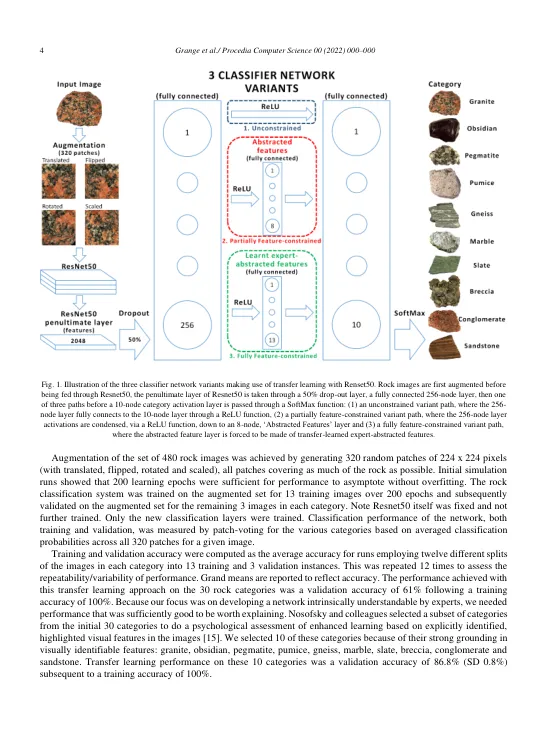

传统上,可解释的人工智能寻求提供高性能黑盒模型(例如深度神经网络)的解释和可解释性。由于此类模型的复杂性很高,因此对其进行解释仍然很困难。另一种方法是强制深度神经网络使用人类可理解的特征作为其决策的基础。我们使用岩石类型的自然类别域测试了这种方法。我们将使用 Resnet50 的迁移学习黑盒实现的性能与首先训练以预测专家识别的特征然后被迫使用这些特征对岩石图像进行分类的网络的性能进行了比较。这个特征约束网络的性能与无约束网络的性能几乎相同。此外,部分受限的网络被迫压缩为少数未使用专家特征进行训练的特征,这不会导致这些抽象特征变得可理解;尽管如此,可以发现这些特征的仿射变换与专家可理解的特征很好地一致。这些发现表明,让人工智能本质上可理解并不一定以牺牲性能为代价。© 2022 作者。由 ELSEVIER B.V. 出版。这是一篇根据 CC BY-NC-ND 许可开放获取的文章(https://creativecommons.org/licenses/by-nc-nd/4.0)由 KES International 科学委员会负责同行评审 关键词:不言自明的人工智能;深度神经网络;迁移学习;XAI;类别学习

XAI & I:促进相互理解的自解释型人工智能

主要关键词