机构名称:

¥ 1.0

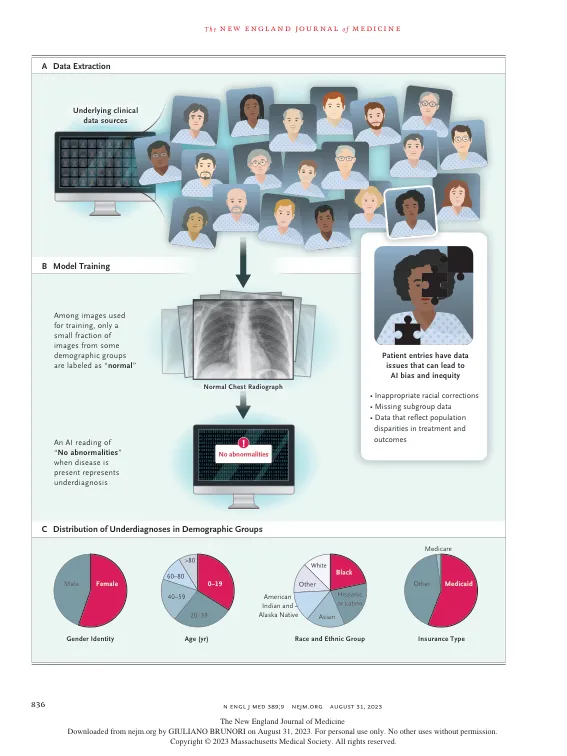

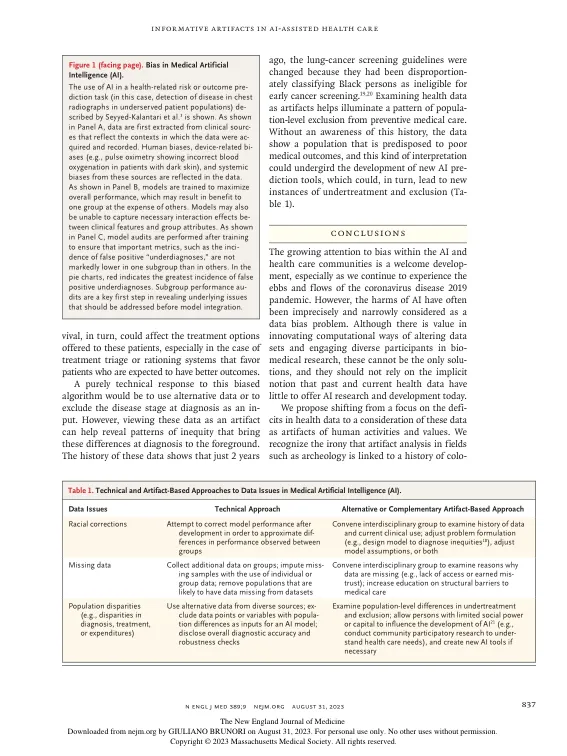

医学中使用的人工智能 (AI) 工具与其他领域中使用的 AI 一样,都是通过检测大量数据中的模式来工作的。AI 工具之所以能够检测到这些模式,是因为它们可以“学习”或被训练来识别数据中的某些特征。然而,使用某种程度上存在偏差的数据训练的医疗 AI 工具可能会出现偏见,当这种偏见与不公正的模式相匹配时,使用这些工具可能会导致不公平和歧视。试图修复用于 AI 训练的有偏见的临床数据等技术解决方案是出于好意,但所有这些举措的基础是这样的观念:有偏差的临床数据是“垃圾”,就像计算机科学谚语所说的“垃圾进,垃圾出”。相反,我们建议将临床数据视为人工制品,经过检查,可以提供有关其所在的社会和机构的信息。

将有偏见的数据视为人工智能辅助医疗中的信息来源