机构名称:

¥ 1.0

案例 A:诊断人工智能中的性别偏见 在不同子群上训练算法可以揭示分类不平衡。最近的一篇论文 (4) 研究了训练集不平衡对基于图像的计算机辅助诊断的影响。作者使用最先进的分类器,使用性别平衡分别为 0/100%、25/75%、50/50%、75/25% 和 100/0% 的女性/男性的训练集,研究了基于胸部 X 光的 12 种不同胸部疾病的诊断。正如预期的那样,当诊断人工智能专门用于诊断女性时,它在女性身上的表现更好,反之亦然。然而,对于某些疾病(例如气胸),专门用于诊断女性的诊断人工智能实际上在诊断男性方面比诊断女性方面要好。将训练集中的部分女性替换为男性会强调这种差异,但事实仍然存在:对女性表现最好的算法在诊断男性方面比对女性表现更好。同时,这是对男性表现最差的算法。

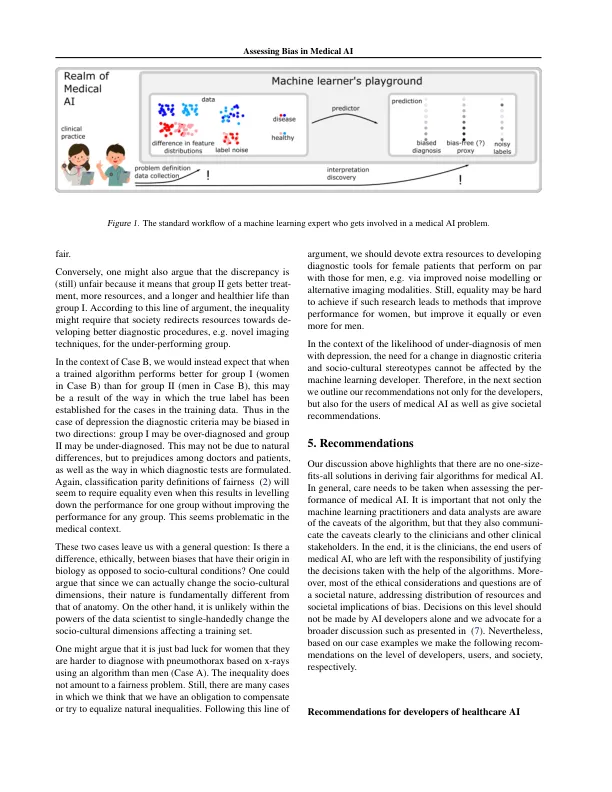

评估医疗人工智能中的偏见