机构名称:

¥ 1.0

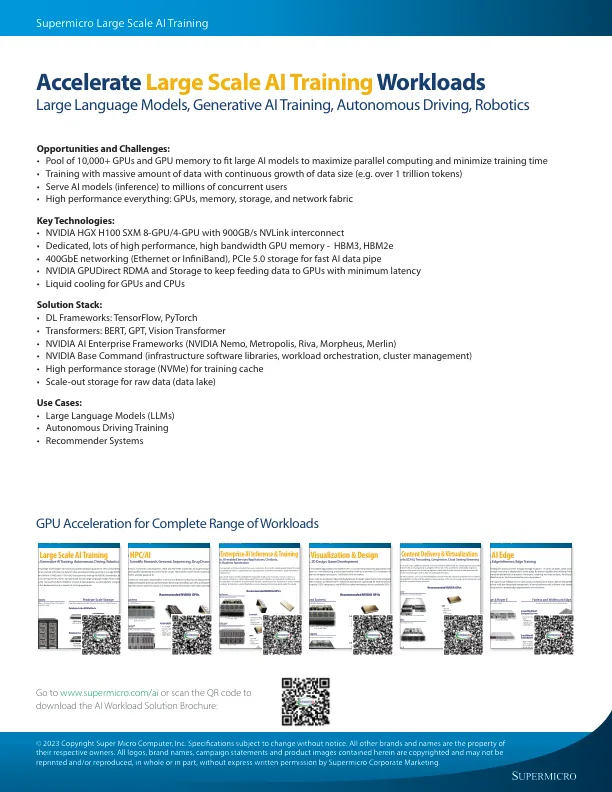

大规模 AI 训练需要尖端技术来最大限度地发挥 GPU 的并行计算能力,以处理数十亿甚至数万亿个 AI 模型参数,这些参数需要使用呈指数级增长的海量数据集进行训练。利用 NVIDIA 的 HGX™ H100 SXM 8-GPU/4-GPU 和最快的 NVLink™ 和 NVSwitch™ GPU-GPU 互连(带宽高达 900GB/s),以及最快的 1:1 网络到每个 GPU 进行节点集群,这些系统经过优化,可在最短的时间内从头开始训练大型语言模型。通过全闪存 NVMe 完成堆栈以实现更快的 AI 数据管道,我们提供带有液体冷却选项的完全集成机架,以确保快速部署和流畅的 AI 训练体验。

大规模人工智能训练