机构名称:

¥ 1.0

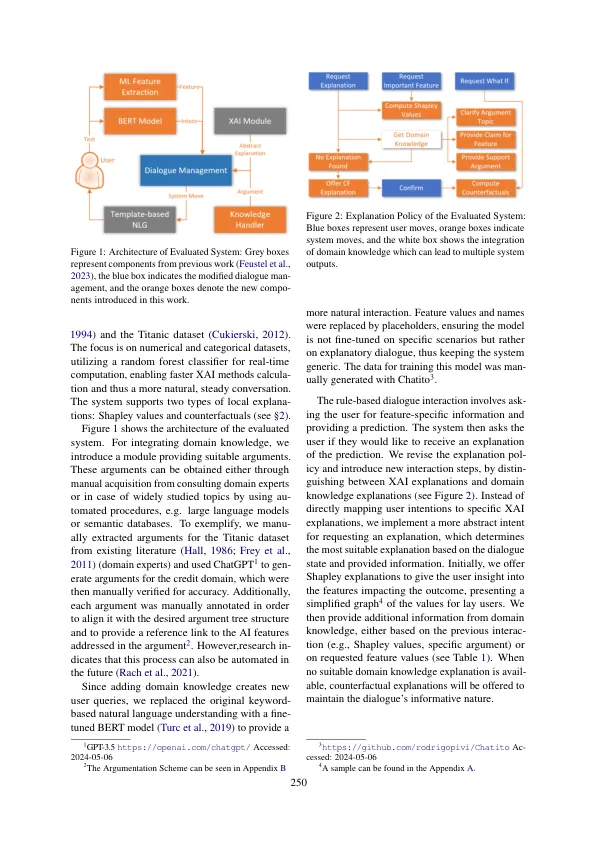

可解释人工智能 (XAI) 是一个快速发展的领域,旨在创建能够为其决策过程提供人类可理解的解释的 AI 系统。然而,这些解释仅依赖于模型和数据特定的信息。为了支持更好的人类决策,将领域知识集成到 AI 系统中有望增强理解和透明度。在本文中,我们提出了一种在对话系统中将 XAI 解释与领域知识相结合的方法。我们专注于源自计算论证领域的技术,将领域知识和相应的解释融入人机对话中。我们在原型系统中实现该方法以进行初步用户评估,其中用户与对话系统交互以从底层 AI 模型接收预测。参与者能够探索不同类型的解释和领域知识。我们的结果表明,当集成领域知识时,用户倾向于更有效地评估模型性能。另一方面,我们发现用户在对话交互过程中并不经常请求领域知识。

具有领域知识的可解释人工智能对话系统方法

主要关键词

![[3] 描述与对话人工智能](/simg/7/7c86aa22bfef59b2ab539b2f12d4997f245270f1.png)