机构名称:

¥ 1.0

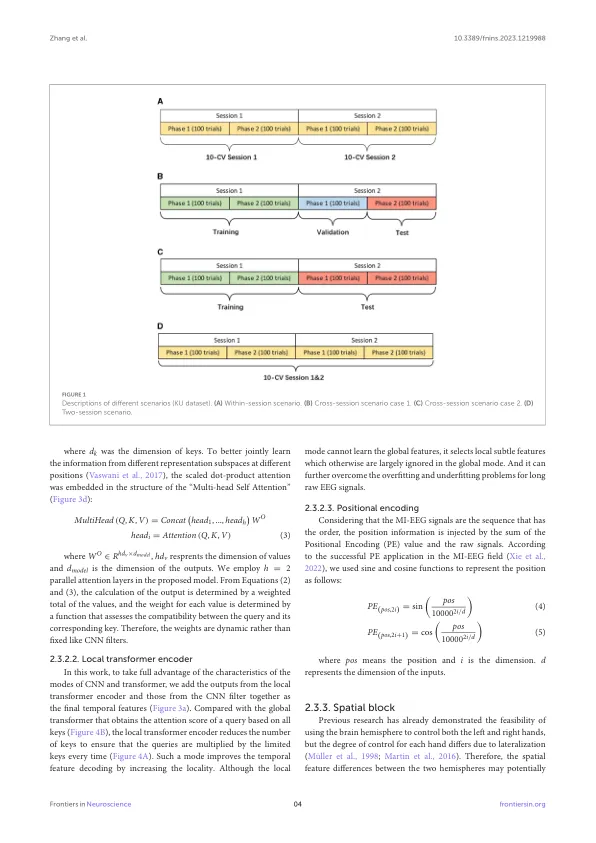

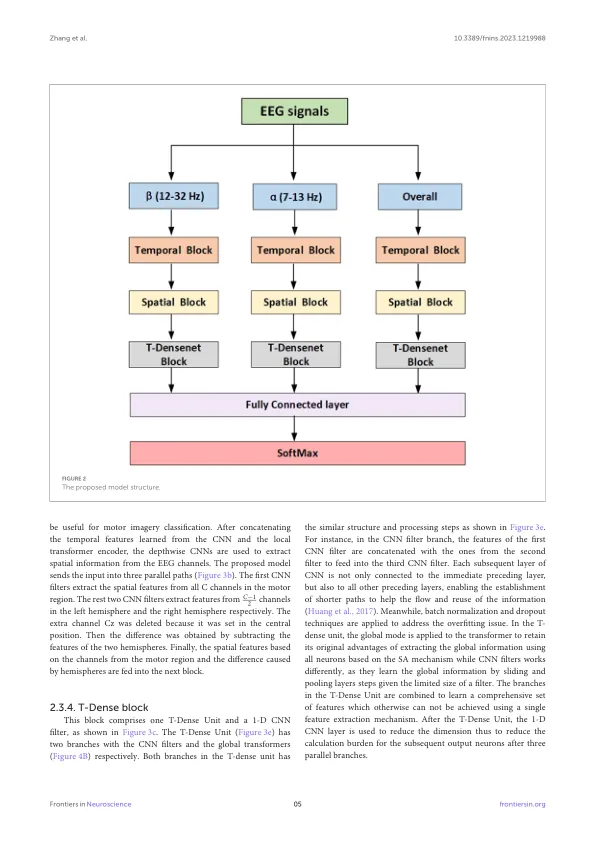

Transformer是一种具有自我注意力机制的深度学习模型,结合了卷积神经网络(CNN),已成功应用于运动成像(MI)脑部计算机界面(BCI)中的解码脑电图(EEG)信号。然而,EEG的极其非线性的非平稳性特征限制了深度学习方法的效果和效率。此外,多种受试者和实验会议都会影响模型适应性。在这项研究中,我们提出了一种基于本地和全球卷积变压器分类的方法。将局部变压器编码器组合在一起,以动态提取时间特征并弥补CNN模型的缺点。获得了所有通道的空间特征和半球的差异以提高模型的鲁棒性。为了获取足够的时间空间特征表示,我们将全局变压器编码器和密集连接的网络结合在一起,以改善信息流和重复使用。为了验证拟议模型的性能,设计了三种包括会议,跨课程和两协议的情况。在实验中,与当前的最新模型相比,在三种情况下,提出的方法在三种情况下分别实现了高达1.46%,7.49%和7.46%的精度。在BCI竞争IV 2A数据集中,拟议的模型还分别为跨课程和两场比赛的情况提高了2.12%和2.21%。结果证实了所提出的方法可以从EEG信号中提取更丰富的MI特征,并改善BCI应用程序中的性能。

基于本地和全球卷积变压器的机车图像EEG分类

主要关键词