机构名称:

¥ 1.0

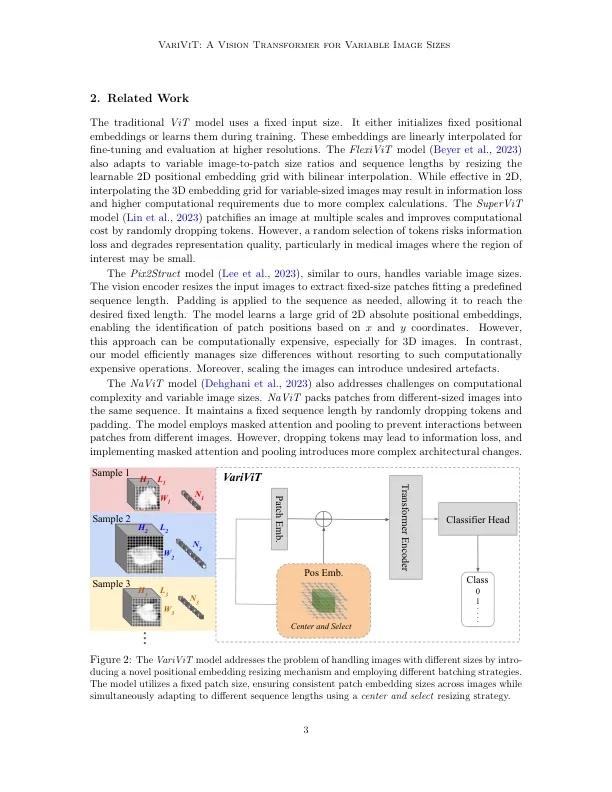

Vision Transformers(VIT)已成为代表学习中最新的架构,利用自我注意的机制在各种任务中脱颖而出。vits将图像分为固定尺寸的补丁,将其限制为预定义的大小,并需要进行预处理步骤,例如调整大小,填充或裁剪。这在医学成像中构成了挑战,尤其是在肿瘤等不规则形状的结构中。一个固定的边界盒子量产生的输入图像具有高度可变的前景与地面比率。进行医学图像可以降低信息并引入人工制品,从而影响诊断。因此,对感兴趣区域的裁缝量化作物可以增强特征代表能力。此外,大图像在计算上是昂贵的,尺寸较小,风险信息损失,表现出计算准确性的权衡。我们提出了Varivit,这是一种改进的VIT模型,该模型制定了用于处理可变图像尺寸的同时保持连贯的贴片大小。varivit采用新颖的位置嵌入调整大小方案,用于可变数量的斑块。我们还将在变量内实施一种新的批处理策略,以降低计算复杂性,从而导致更快的培训和推理时间。在我们对两个3D脑MRI数据集的评估中,变量超过了胶质瘤基因型预测和脑肿瘤分类中的香草vits和重新连接。它的F1得分分别为75.5%和76.3%,学习了更多的判别特征。与常规体系结构相比,我们提出的批处理策略将计算时间最多减少了30%。这些发现强调了图像表示学习中变量的功效。关键字:视觉变压器,建筑,表示,肿瘤分类

变量:可变图像大小的视觉变压器

主要关键词