机构名称:

¥ 1.0

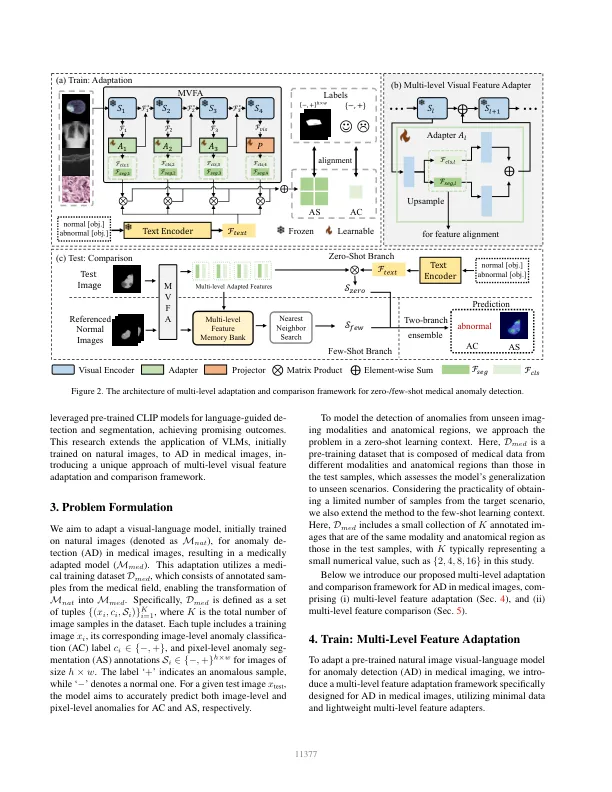

大规模视觉语言预训练模型的最新进展已在自然图像领域中的零样本/少样本异常检测方面取得了重大进展。然而,自然图像和医学图像之间巨大的领域差异限制了这些方法在医学异常检测中的有效性。本文介绍了一种新颖的轻量级多级自适应和比较框架,以重新利用 CLIP 模型进行医学异常检测。我们的方法将多个残差适配器集成到预训练的视觉编码器中,从而实现不同级别视觉特征的逐步增强。这种多级自适应由多级、逐像素的视觉语言特征对齐损失函数引导,将模型的重点从自然图像中的对象语义重新校准到医学图像中的异常识别。调整后的特征在各种医学数据类型中表现出更好的泛化能力,即使在模型在训练期间遇到看不见的医学模态和解剖区域的零样本场景中也是如此。我们在医学异常检测基准上进行的实验表明,我们的方法明显优于当前最先进的模型,在零样本和少样本设置下,异常分类的平均 AUC 改进分别为 6.24% 和 7.33%,异常分割的平均 AUC 改进分别为 2.03% 和 2.37%。源代码可从以下网址获取:https://github.com/MediaBrain-SJTU/MVFA-AD

调整视觉语言模型以实现医学图像中的通用异常检测

主要关键词