机构名称:

¥ 1.0

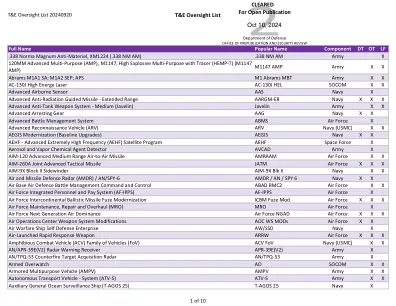

为了破译人脑的语言表示基础的算法,先前的工作通过对NLU任务进行了微调的预先调整的预先训练的人工神经网络(ANN)模型对大脑对语言输入的反应。然而,完整的微调通常会更新整个参数空间并扭曲预训练的功能,从而与大脑的强大多任务学习无关。及时调整可以保护预训练的权重,并学习特定于任务的嵌入以适合任务。迅速调整是否会产生代表,可以更好地说明大脑语言表示的比较?如果是这样,什么样的NLU任务会导致预先训练的模型更好地解码人脑中所代表的信息?我们通过比较神经解码中的迅速调整和微调的表示来调查这些问题,这预测了刺激引起的大脑活动的语言刺激。我们发现,在10个NLU任务中,全面的微调都没有明显胜过神经解码的迅速调整,这意味着一种更一致的调谐方法会产生代表性的代表,可以更好地与大脑数据相关。更重要的是,我们确定处理精细概念的任务意味着比其他任务更好地解码大脑激活模式的屈服表示,尤其是句法构成任务。这表明我们的大脑编码代表语言时浅层句法信息更细粒度的概念信息。

微调与及时调节的监督陈述

主要关键词