机构名称:

¥ 1.0

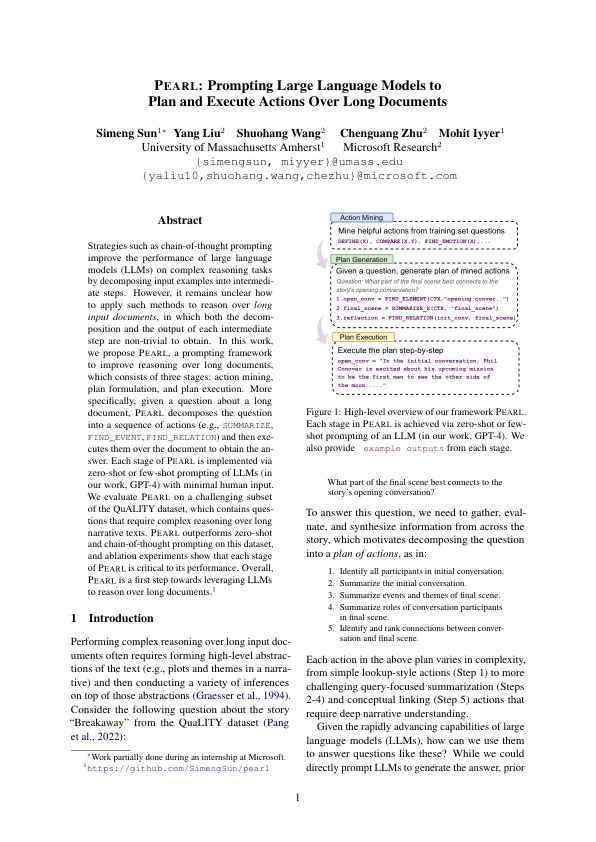

思路链提示等策略通过将输入示例分解为中间步骤来提高大型语言模型 (LLM) 在复杂推理任务上的性能。然而,如何将这些方法应用于长输入文档的推理仍不清楚,因为获得每个中间步骤的分解和输出都不容易。在这项工作中,我们提出了 P EARL,一个用于改进长文档推理的提示框架,它包括三个阶段:动作挖掘、计划制定和计划执行。更具体地说,给定一个关于长文档的问题,P EARL 将问题分解为一系列动作(例如,SUMMARIZE、FIND_EVENT、FIND_RELATION),然后在文档上执行这些动作以获得答案。P EARL 的每个阶段都是通过零样本或少样本提示 LLM(在我们的工作中为 GPT-4)来实现的,需要最少的人工输入。我们在 QuALITY 数据集的一个具有挑战性的子集上评估了 P EARL,其中包含需要对长篇叙述文本进行复杂推理的问题。P EARL 在这个数据集上的表现优于零样本和思维链提示,消融实验表明 P EARL 的每个阶段对其性能都至关重要。总的来说,P EARL 是利用 LLM 推理长文档的第一步。1

PEARL:促使大型语言模型规划和......