机构名称:

¥ 1.0

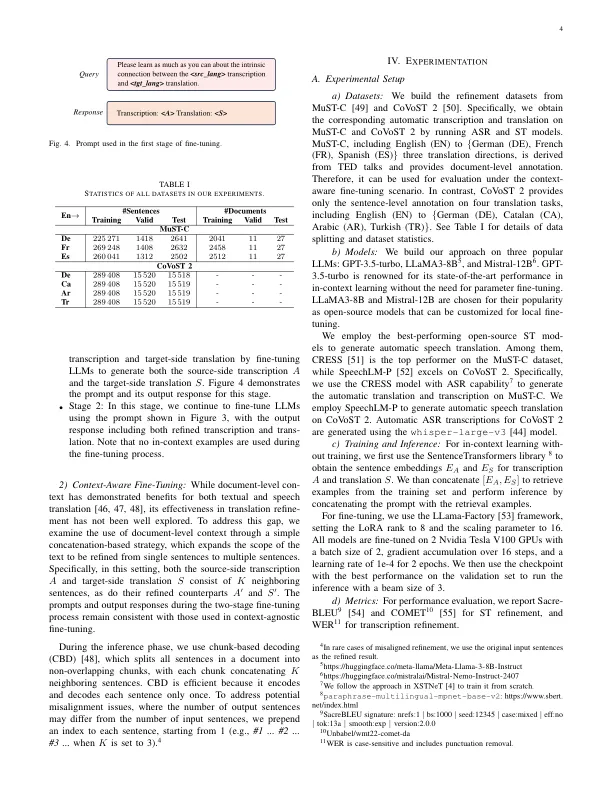

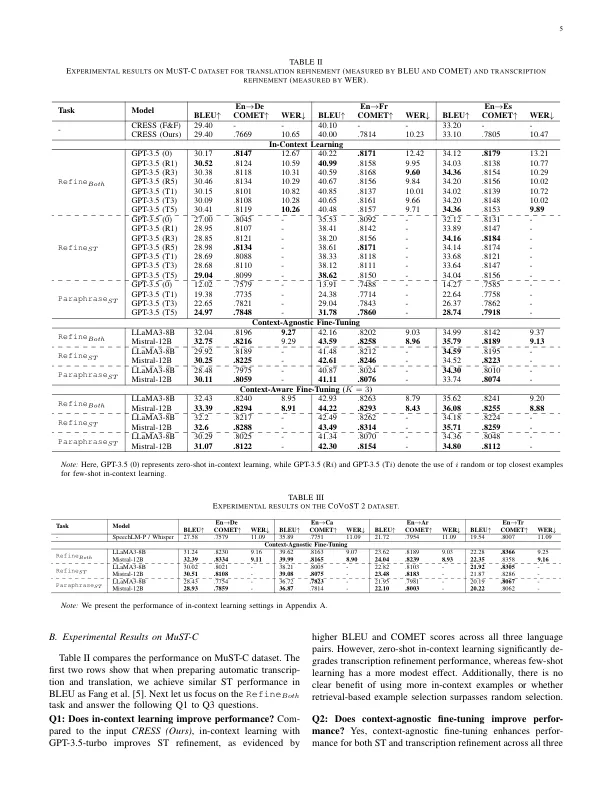

摘要 — 大型语言模型 (LLM) 的最新进展已在各种语言任务中展示了其卓越的能力。受文本到文本翻译细化成功的启发,本文研究了 LLM 如何通过引入联合细化过程来提高语音翻译的性能。通过 LLM 对语音翻译 (ST) 和自动语音识别 (ASR) 转录进行联合细化,ST 模型的性能在无需训练的上下文学习和参数高效的微调场景中都得到了显着提高。此外,我们还探讨了在上下文感知微调场景下文档级上下文对细化的影响。在包含七个翻译任务的 MuST-C 和 CoVoST 2 数据集上的实验结果证明了使用包括 GPT-3.5-turbo、LLaMA3-8B 和 Mistral-12B 在内的几种流行 LLM 所提出方法的有效性。进一步的分析进一步表明,与单独细化翻译相比,联合细化转录和翻译可获得更好的性能。同时,结合文档级上下文可显著提高细化性能。我们在 GitHub 1 上发布了我们的代码和数据集。

使用大型语言模型进行语音翻译细化