机构名称:

¥ 1.0

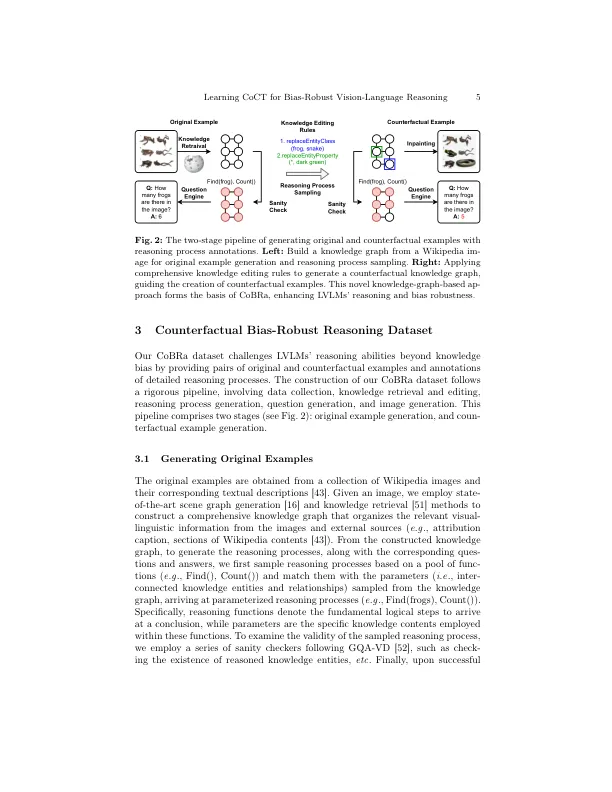

摘要。尽管大型视力语言模式(LVLM)在各种任务上取得了显着的成功,但由于训练数据而继承的对知识偏见的敏感性阻碍了它们概括为新场景并限制其现实世界中适用性的能力。为了解决这一挑战,我们提出了反事实偏见推理(COBRA)数据集,该数据集通过提供新颖的VQA示例来解决知识偏见,以评估和减轻LVLMS中的偏见。这些例子通过提供编辑的知识图和图像内容来鼓励反事实思考,并详细介绍了理性过程的注释,以促进对示例的全面理解。基于数据集,我们介绍了一系列反事实思想(COCT)方法,该方法学习了偏见的推理过程,并提供了在上下文中的示例,以证明现有推理如何推广到反事实场景。这使LVLMS能够逐步阐明原因,而不是依靠有偏见的知识,导致更具概括性的解决方案。我们广泛的评估表明,CoCT在需要知识偏见下需要推理的任务上的现有方法优于现有方法。我们的工作可从https://github.com/superjohnzhang/cobra获得。

对反事实思维的学习链,以偏见的视觉语言推理