机构名称:

¥ 1.0

机器学习的应用在医学和健康中变得越来越普遍,从而实现了更准确的预测模型。但是,这通常以相互可预性为代价,从而限制了机器学习方法的临床影响。要意识到医疗保健中机器学习的潜力,从多个利益相关者和各个角度的透明度中理解此类模型至关重要,需要不同类型的解释。从这个角度来看,我们激励和探索了五种根本不同类型的事后机器学习解释性。我们强调了它们提供的不同信息,并描述了每个信息何时有用。我们研究了医疗保健领域的各种利益相关者,探讨了他们的特定目标,要求和目标。我们讨论当前的可解释性概念如何帮助满足这些概念以及每个利益相关者使机器学习模式在临床上产生影响的要求。最后,为了促进采用,我们发布了一个开源可解释性库(https://github.com/vanderschaarlab/interpretability),其中包含不同类型的可解释性的实现,包括可视化和探索解释的工具。

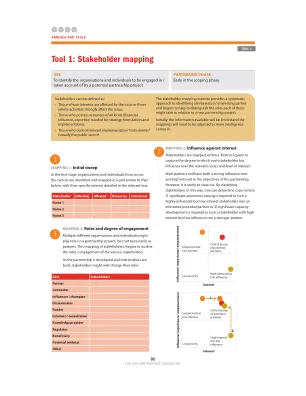

多个利益相关者在医疗保健中推动了机器学习的多种可解释性要求