机构名称:

¥ 1.0

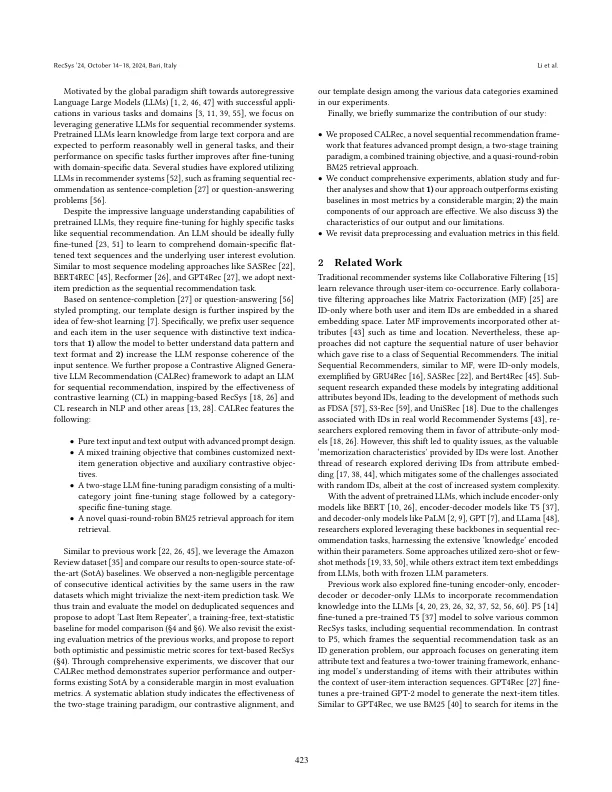

传统的推荐系统(例如矩阵分解方法)主要集中于学习共享密集的设备空间,以表示项目和用户偏好。sub-sub-sub,诸如RNN,GRUS和最近的序列模型在顺序推荐的任务中出现并出色。此任务需要了解用户历史交互中存在的顺序结构,以预测他们可能喜欢的下一个项目。基于大型语言模型(LLM)在各种任务中的成功,最近使用在庞大的文本中鉴定的LLM进行了研究,以进行顺序建议。要使用LLM进行顺序推荐,用户交互的历史记录和模型对下一个项目的预测都以文本形式表示。我们提出了CALREC,这是一种两阶段的LLM登录框架,它使用两种对比性损失和语言建模损失的混合物以两位较高的方式对经过验证的LLM进行了验证:LLM首先是在来自多个域中的数据混合物上进行的,随后是一个目标域芬特芬特登录。我们的模型极大地胜过许多最先进的基准( + 37%的回忆@1和ndcg@10中的24%),我们的系统消融研究表明,(i)两种固定阶段至关重要,当结合使用时,我们在相反的绩效中获得了相似的绩效,以及(ii)对比的一致性在目标域中有效地探索了我们的实验。

calrec:依次推荐的生成LLM的对比度对准

主要关键词