机构名称:

¥ 1.0

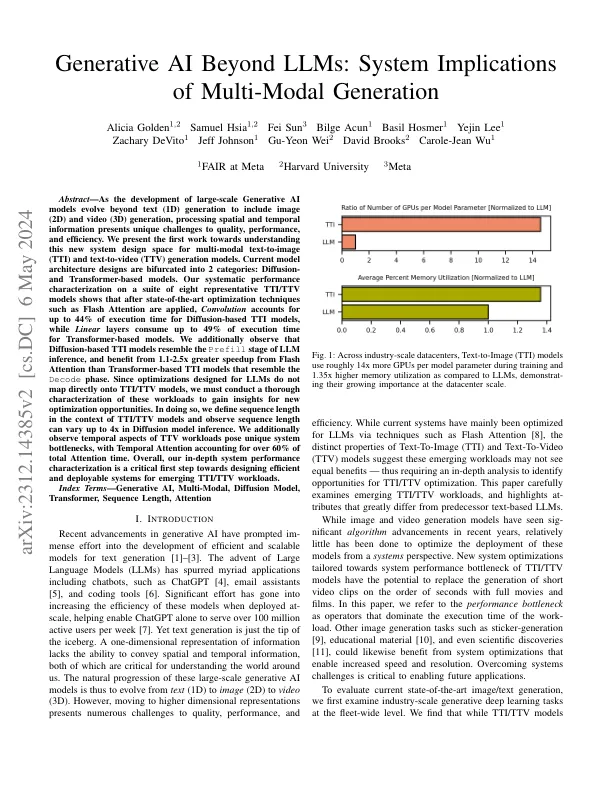

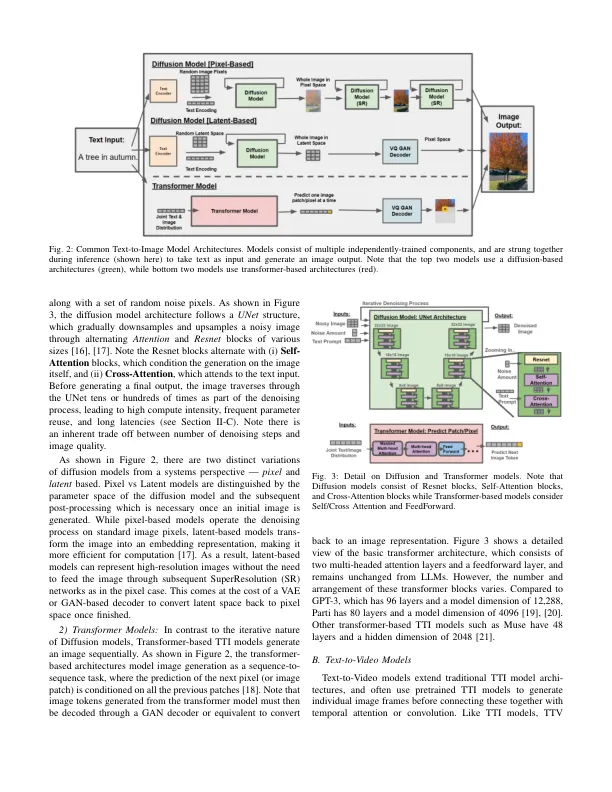

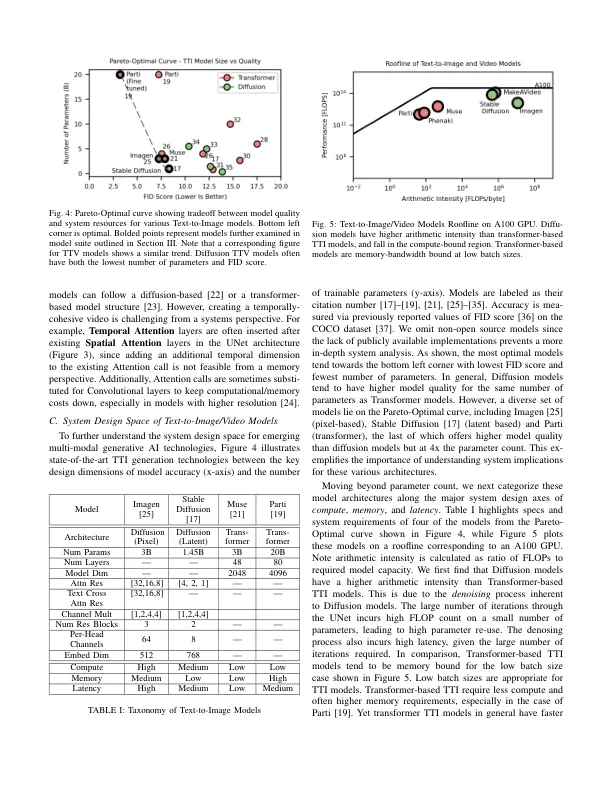

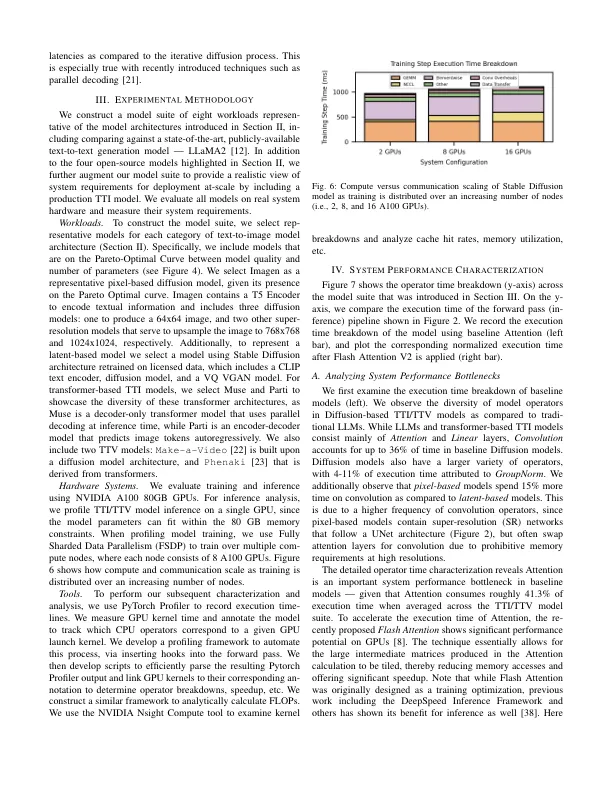

摘要 - 随着大规模生成的AI模型的开发超出文本(1D)生成,包括图像(2D)和视频(3D)生成,处理空间和时间信息对质量,性能和效率提出了独特的挑战。我们介绍了为理解多模式文本对图像(TTI)和文本对视频(TTV)生成模型的新系统设计空间的第一项工作。当前的模型架构设计分为两类:基于扩散和变压器的模型。我们在八个代表性TTI/TTV模型的套件上进行系统的性能表征表明,应用了最新的优化技术(例如闪光灯注意),卷积占基于扩散的TTI模型的44%的执行时间,而线性层为Transfere基于变速器的模型的执行时间最多49%。我们还观察到,基于扩散的TTI模型类似于LLM推理的预填充阶段,并且受益于闪光灯的1.1-2.5倍比类似于解码阶段的TTI模型高1.1-2.5倍。由于为LLMS设计的优化未直接映射到TTI/TTV模型上,因此我们必须对这些工作负载进行彻底的表征,以获得新的优化机会的见解。在这样做时,我们在TTI/TTV模型的上下文中定义了序列长度,并且在扩散模型推断中观察到序列长度最高为4倍。我们还观察到TTV工作负载的时间方面构成了独特的系统瓶颈,时间注意力占总注意力时间的60%以上。总的来说,我们深入的系统性能表征是设计有效且可部署的系统的重要第一步,以实现新兴的TTI/TTV工作负载。索引项 - 生成AI,多模式,扩散模型,变压器,序列长度,注意力

生成的AI超出LLM:多...

主要关键词