机构名称:

¥ 4.0

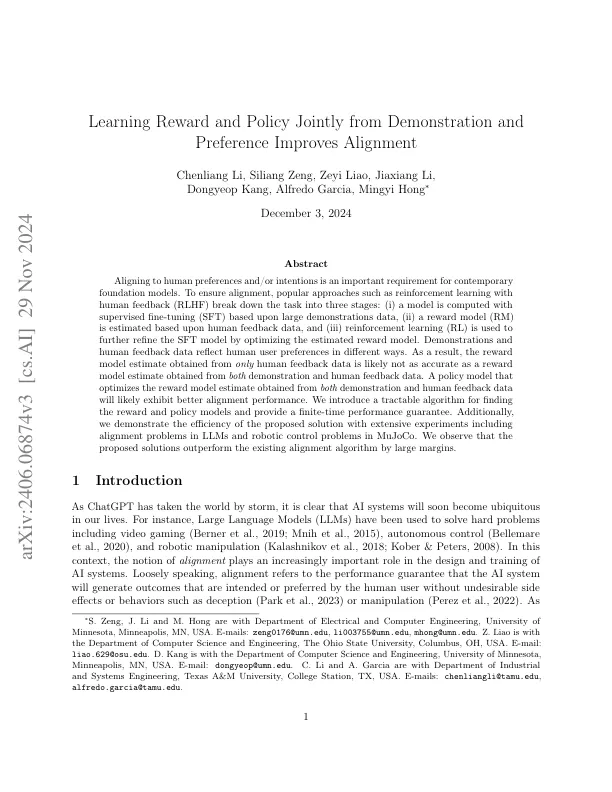

与人类的偏好和/或意图保持一致是当代基础模型的重要要求。为了确保对准,诸如人类反馈(RLHF)等流行方法将任务分为三个阶段:(i)基于大型示范数据的监督微调(SFT)计算的模型,(ii)基于人类反馈数据和(III II)的估计,(ii)将使用(III)估算了(ii II),以进一步的模型(RL)进一步估算了该模型(RL)。演示和人类反馈数据以不同的方式反映了人类用户的偏好。结果,仅从人类反馈数据获得的奖励模型估计可能不如从演示和人类反馈数据获得的奖励模型估计值那么准确。一种优化从演示和人类反馈数据获得的奖励模型估计值的政策模型可能会表现出更好的对齐性能。我们引入了一种可访问的算法,以找到奖励和政策模型并提供有限的时间绩效保证。此外,我们通过广泛的实验(包括LLMS中的比对问题和Mujoco中的机器人控制问题)来证明所提出的解决方案的效率。我们观察到,所提出的解决方案的表现优于现有的对齐算法。

从演示和偏好共同学习奖励和政策可以改善一致性