机构名称:

¥ 1.0

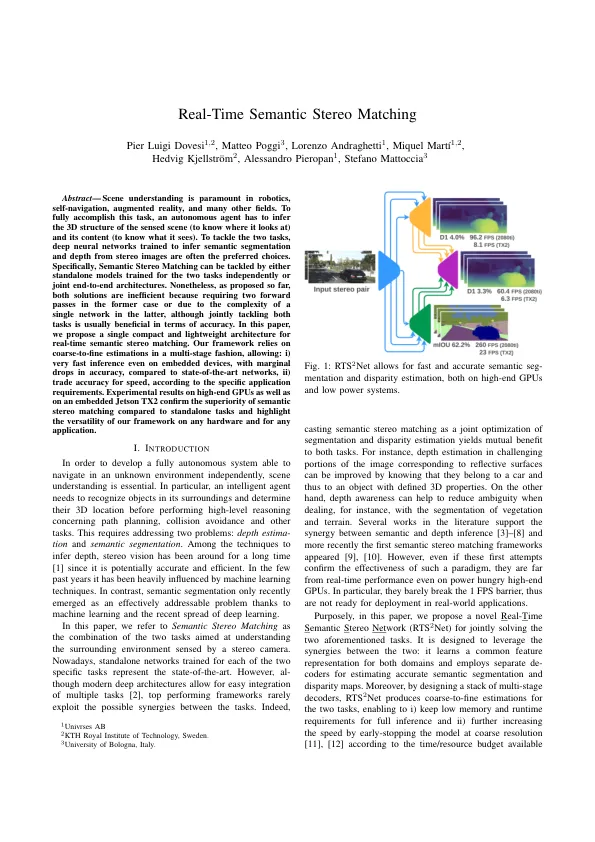

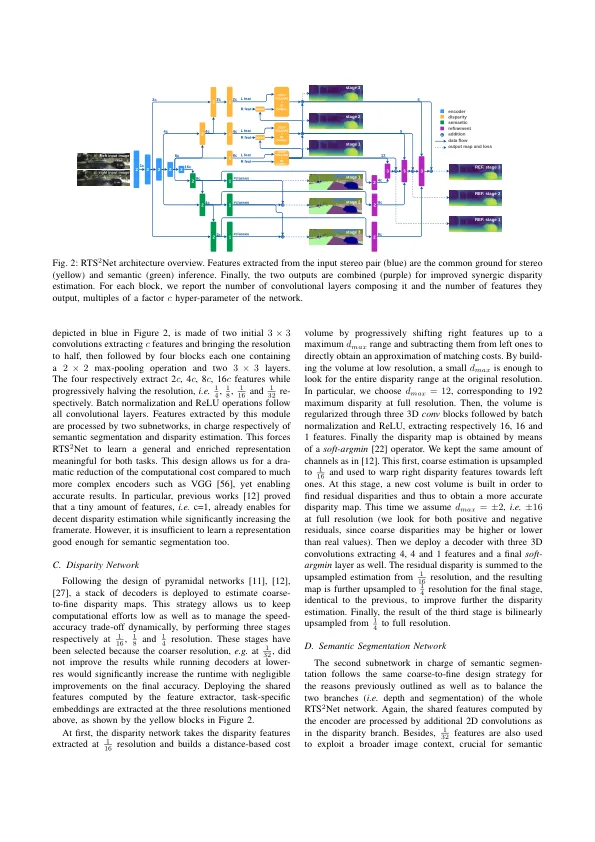

摘要 - 场景的理解在机器人技术,自动化,增强现实和许多其他领域至关重要。为了完全完成此任务,一个自主代理必须推断感应场景的3D结构(要知道它的位置)及其内容(了解它看到的内容)。为了解决这两个任务,经过训练的深度神经网络,从立体声图像中推断出语义细分和深度通常是首选的选择。特别是,可以独立训练这两个任务的独立模型或端到端的端到端体系结构来解决语义立体声匹配。到目前为止,这两种解决方案都是不具备的,因为在前一种情况下需要两个正向通行证,或者由于后者中单个网络的复杂性,尽管共同解决这两种任务通常在准确性方面是有益的。在本文中,我们为实时语义立体声匹配提供了一个紧凑而轻巧的体系结构。我们的框架以多阶段的方式依赖于粗到实体的估计,允许:i)即使在嵌入式设备上也非常快速推断,并且与最先进的网络相比,准确性下降的准确性下降,ii)根据特定的应用程序要求,速度的贸易准确性。与独立任务相比,在高端GPU以及嵌入式Jetson TX2上确保语义立体声匹配的优越性,并突出了我们框架在任何硬件和任何应用程序上的多功能性。

实时语义立体声匹配-IRIS

主要关键词