机构名称:

¥ 1.0

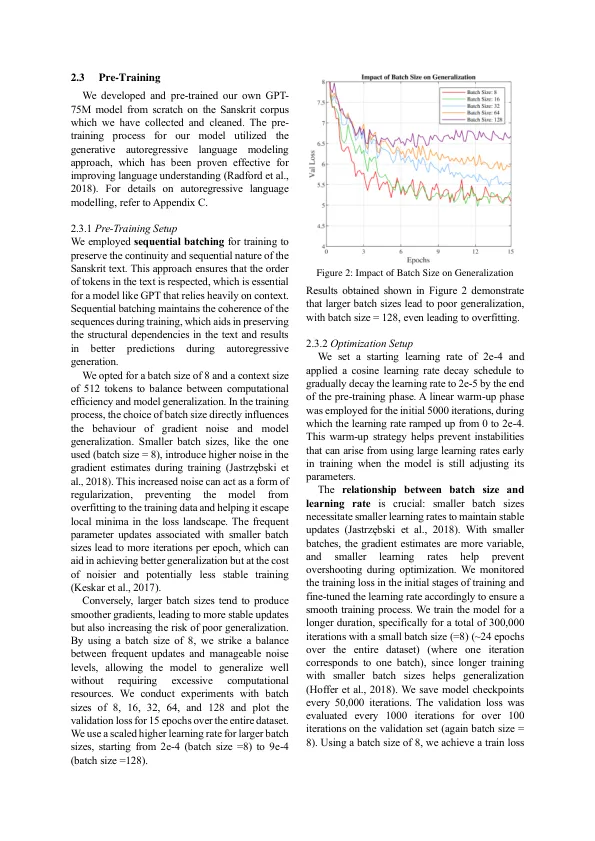

在过去的十年中,在数字化梵语文本和推进语言的计算分析方面取得了重大进展。然而,为促进NLP的努力促进了诸如语义类比预测,命名实体识别和其他人的复杂语义下游任务,而其他人仍然有限。此差距主要是由于缺乏建立在大规模梵文文本数据上的坚固,预先训练的梵文模型,因为这需要大量的计算资源和数据准备。在本文中,我们介绍了Sansgpt,这是一种生成的预培训模型,已在大量的梵文文本上进行了培训,旨在促进下游NLP任务的微调和开发。我们的目标是该模型是推进梵语NLP研究的催化剂。此外,我们开发了一种专门针对梵语文本优化的自定义令牌,从而实现了复合词的有效令牌化,并使其更适合生成任务。我们的数据收集和清洁过程涵盖了各种各样的可用梵文文献,以确保培训的全面代表。我们通过对语义类比预测和明喻元素提取进行微调来进一步证明该模型的疗效,分别达到了大约95.8%和92.8%的令人印象深刻的精度。

sansgpt:在梵语中推进生成预培训

主要关键词