机构名称:

¥ 1.0

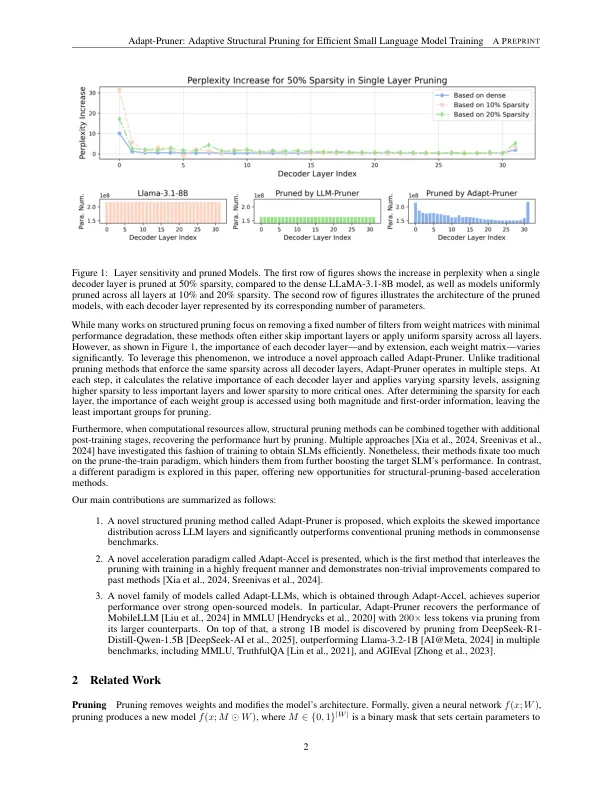

小语言模型(SLM)由于在边缘设备中的广泛应用而引起了学术界和行业的极大关注。为了获得具有强大性能的SLM,传统方法要么从头开始预训练模型,这会产生大量的计算成本,或者压缩/修剪现有的大语言模型(LLMS),这会导致性能下降,并且与预训练相比差不多。在本文中,我们研究了涉及结构化修剪和模型训练的加速方法家族。我们发现1)层面的适应性修剪(适应性培训)在LLM中非常有效,并且对现有的修剪技术的改善具有显着改善,2)适应性修剪,配备了进一步的训练导致模型,可与模型相当,与那些从抓挠中进行预训练的模型相当,3)逐步训练,仅通过促进培训,而仅通过互动而进行较小的培训(仅在较小的培训中),并且仅通过互动而进行互动(仅在较小的情况下),并且促进了较小的培训。一次5%)。对Llama-3.1-8b的实验结果表明,适应性抗性的表现要优于常规修剪方法,例如LLM-PRUNER,FLAP和SLICEGPT,平均在平均基准的准确度中以1%-7%的速度为1%-7%。此外,改编普朗纳(Adapt-Pruner)在MMLU基准测试上恢复了Mobilellm-125m的性能,并通过从其较大的对应物中修剪来降低代币,并发现了超过多个基准标记Llama-3.2-1B的新型1B模型。

Adapt-Prouner:适应性的结构修剪,用于有效的小语言模型培训

主要关键词