机构名称:

¥ 2.0

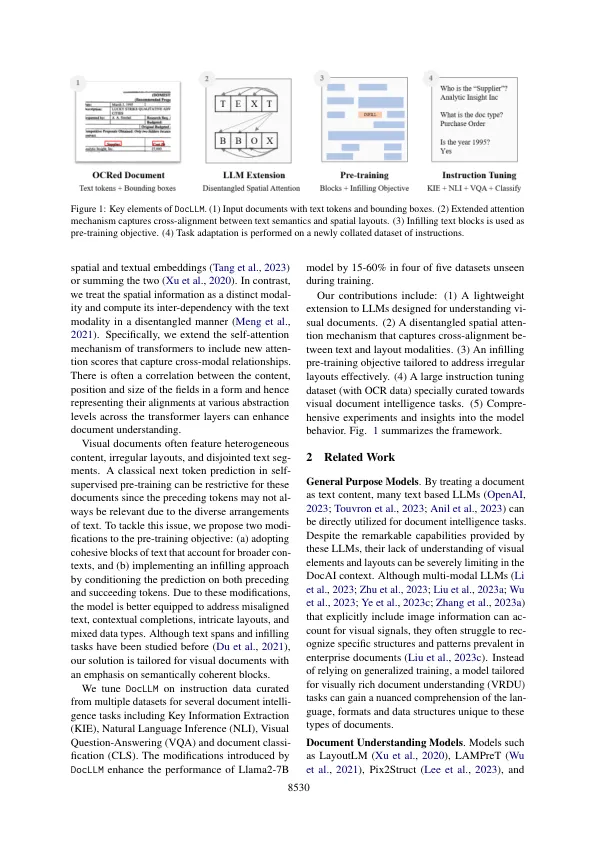

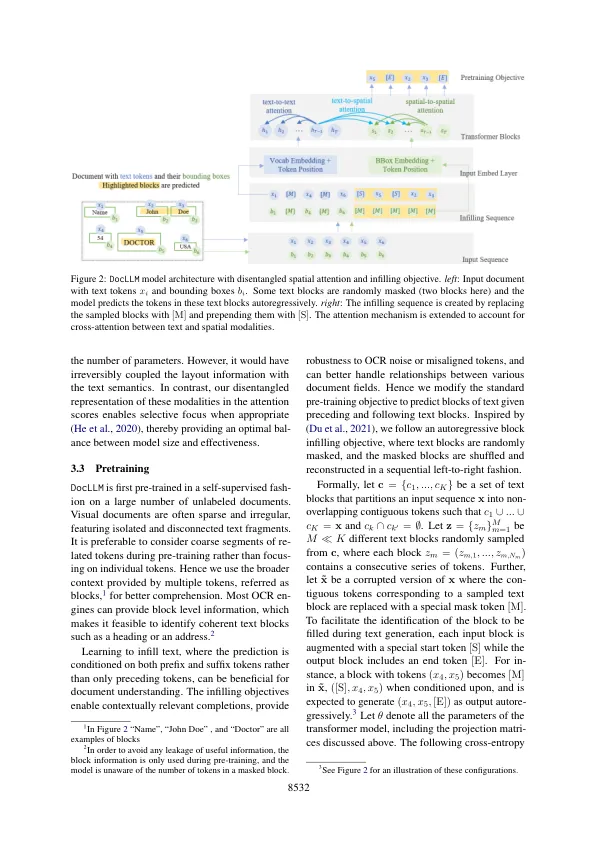

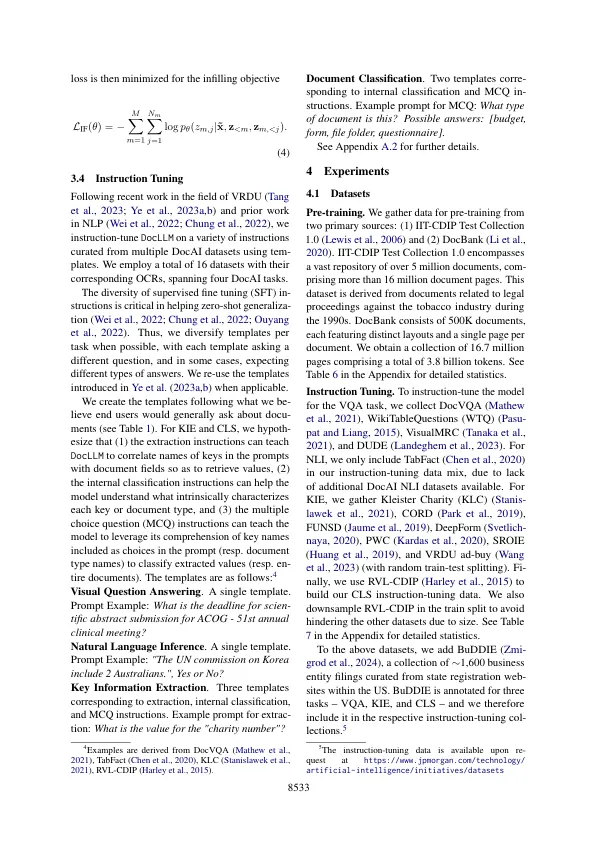

企业文档,例如表格,收据,报告和其他此类记录,通常在文本和规范模式的交集中携带丰富的语义。其复杂布局提供的视觉提示在有效地培养这些文档中起着至关重要的作用。在此过程中,我们提出了Docllm,这是传统大型语言模型(LLMS)的轻量级扩展,以考虑文本语义和空间布局,以通过视觉文档进行推理。我们的模型通过避免昂贵的图像编码器并专注于边界框信息以结合空间外部结构,这与现有的Mul- Timodal llms不同。具体而言,文本和空间方式之间的交叉对齐是通过将经典变压器中的注意机制分解为一组分离的矩阵来捕获的。此外,我们设计了一个学会填充文本段的预训练目标。这种方法使我们能够解决视觉文档中经常遇到的不规则布局和异质内容。使用大规模的指定数据集对预训练的模型进行了微调,涵盖了四个核心文档中的识别任务。我们证明,在所有任务中,在16个数据集中的14个数据集中,我们的解决方案的表现优于Sota LLMS,并概括为5个以前看不见的数据集中的4个。

docllm:用于多模式文档理解的布局感知的生成语言模型

主要关键词

![使用生成AI语言模型(2024年11月12日)[1]](/simg/9/960fbacbc2e3afa5a9983fb3cc1d65b0c0a766a7.webp)