机构名称:

¥ 1.0

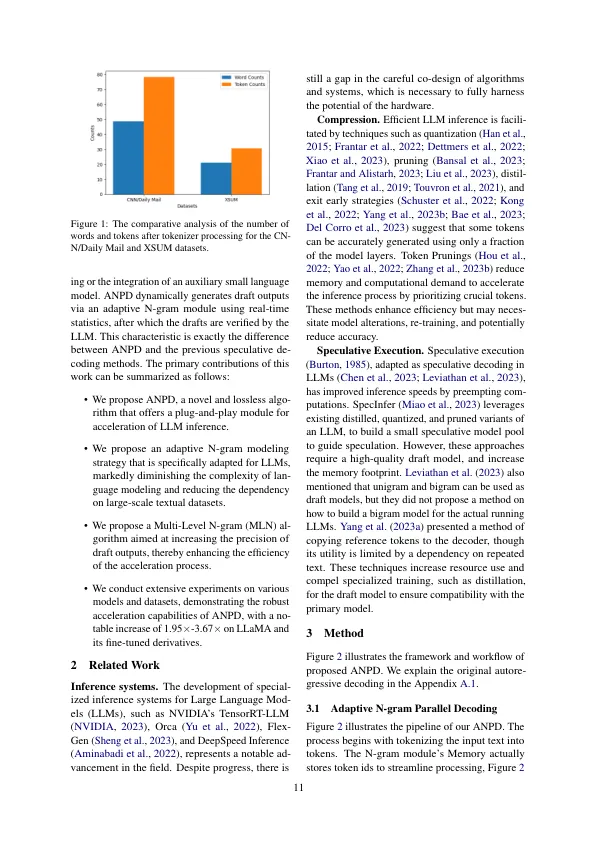

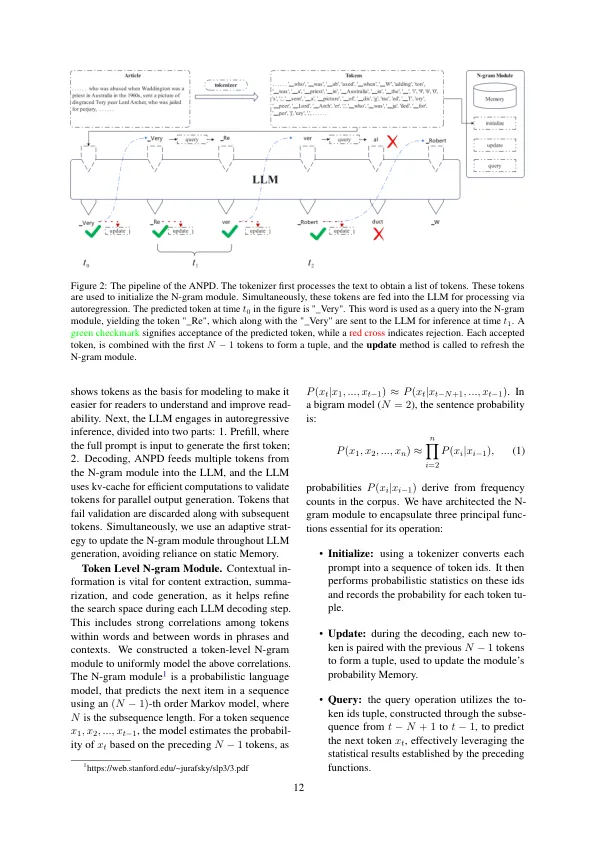

尽管大型语言模型(LLM)表现出了显着的能力,但由于自动回归过程,资源消耗和相当大的潜伏期所阻碍它们。在这项研究中,我们引入了自适应n克平行解码(ANPD),这是一种创新和无损的方法,通过允许同时产生多个代币来加速推断。ANPD结合了两级方法:它从采用N-Gram模块的快速起草阶段开始,该模块根据当前的交互式环境进行适应,然后是验证阶段,在此期间,原始LLM评估并确认了拟议的令牌。因此,ANPD预示着LLM原始外的完整性,同时提高了处理速度。我们利用N-Gram模块的多级体系结构来增强初始草稿的精度,从而减少了推理潜伏期。ANPD消除了重新培训或额外的GPU内存的需求,从而使其具有有效的插件增强功能。在我们的实验中,诸如美洲驼及其微调变体之类的模型显示出高达3的速度提高。67×,验证了我们提出的ANPD的有效性。

PCA基础:评估感知认知链中的多模式大语言模型

主要关键词