机构名称:

¥ 4.0

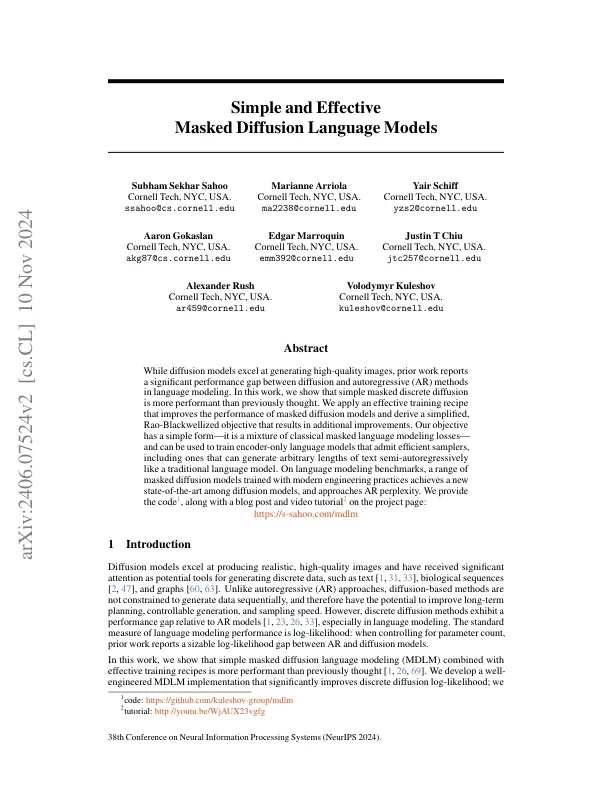

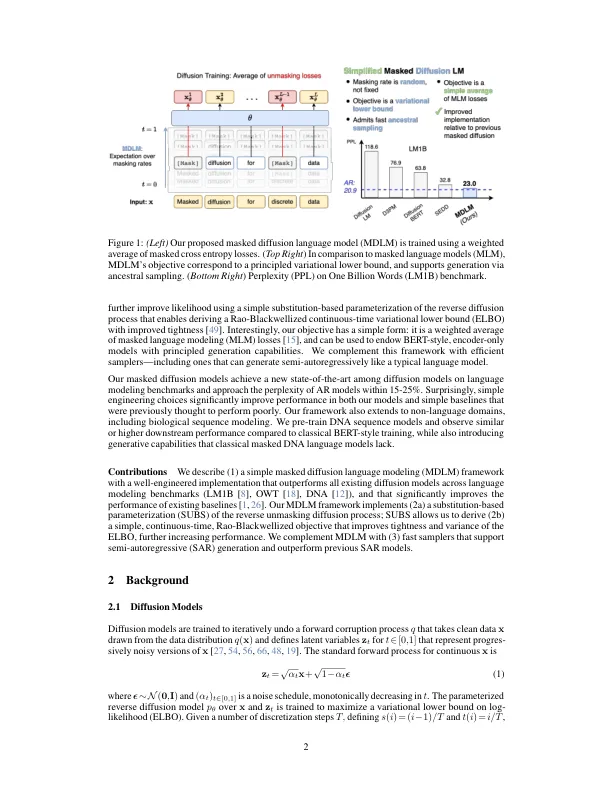

虽然扩散模型擅长生成高质量图像,但先前的研究报告称,在语言建模中,扩散和自回归 (AR) 方法之间存在显著的性能差距。在这项工作中,我们表明简单的掩蔽离散扩散比以前认为的更有效。我们应用了一种有效的训练方法,可以提高掩蔽扩散模型的性能,并推导出一个简化的 Rao-Blackwellized 目标,从而带来额外的改进。我们的目标形式简单——它是经典掩蔽语言建模损失的混合——可用于训练仅编码器的语言模型,这些模型可以接受高效的采样器,包括可以像传统语言模型一样半自回归生成任意长度文本的采样器。在语言建模基准上,一系列使用现代工程实践训练的掩蔽扩散模型在扩散模型中达到了新的最先进水平,并接近 AR 困惑度。我们在项目页面上提供了代码 1 以及博客文章和视频教程 2:

简单有效的掩蔽扩散语言模型

主要关键词