机构名称:

¥ 2.0

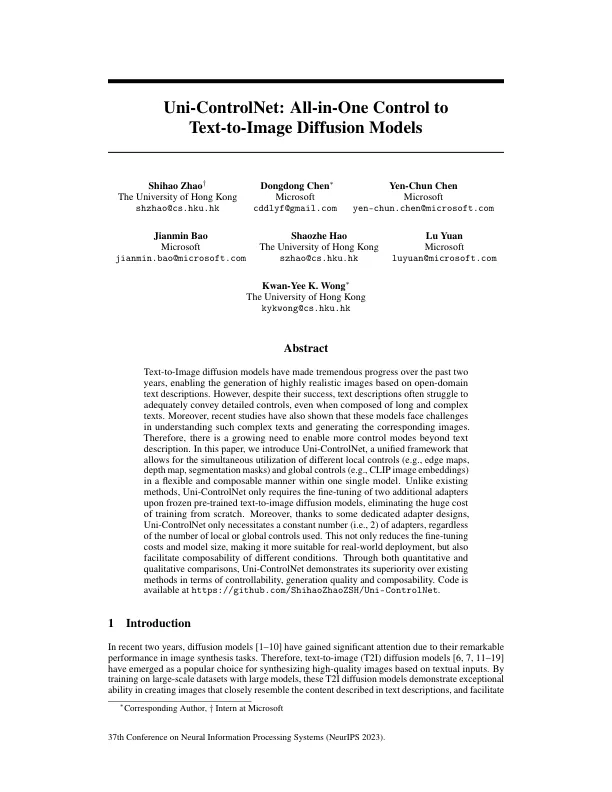

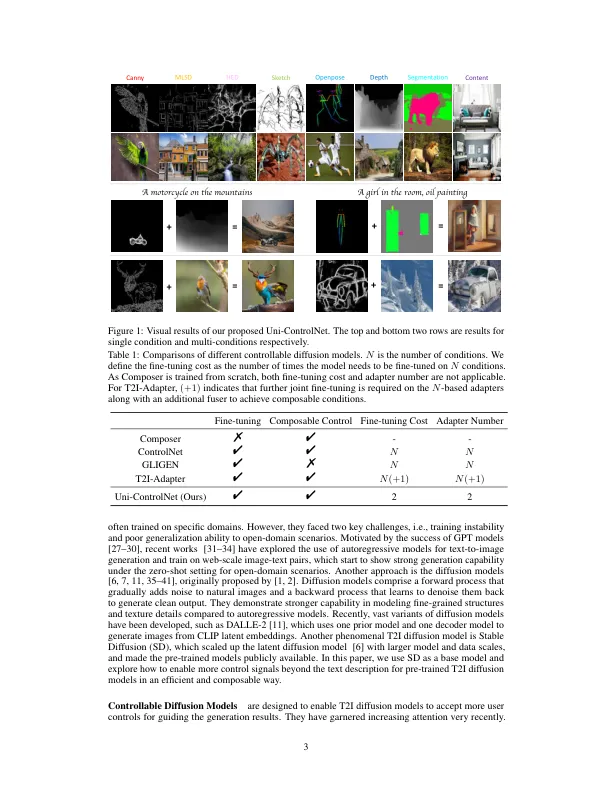

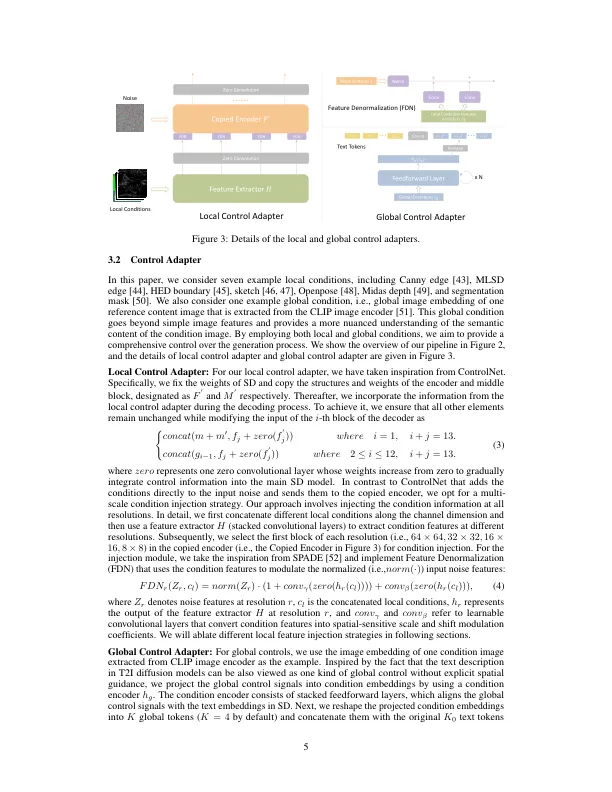

文本到图像扩散模型在过去两年中取得了巨大的进步,从而可以基于开放域文本描述产生高度逼真的图像。,尽管它们成功,但文本描述通常也很难充分传达详细的控制,即使是由长长而复杂的文本组成的。此外,最近的研究还表明,这些模型在理解此类复杂文本和生成相应图像方面面临挑战。因此,越来越需要在文本描述之外启用更多的控制模式。在本文中,我们引入了Uni-Controlnet,这是一个统一的框架,允许同时利用不同的本地控件(例如,边缘地图,深度图,分割掩码)和全局控件(例如,剪辑掩码)(例如,剪贴图像嵌入),以一种单个模型的柔性和可构成方式。与现有方法不同,Uni-Controlnet仅需要在冷冻预训练的文本到图像扩散模型时对两个附加适配器进行微调,从而消除了从头开始的巨大培训成本。此外,由于一些专用的适配器设计,uni-controlnet只需要一个恒定数字(即2),而不管使用的本地或全局控件的数量如何。这不仅降低了微调成本和模型大小,因此更适合于现实世界的部署,而且还促进了不同条件的合成性。通过定量和定性比较,在可控性,发电质量和合成性方面,Uni-Controlnet展示了其优于现有方法的优势。代码可在https://github.com/shihaozhaozsh/uni-controlnet上找到。

uni-controlnet:多合一控制到文本对图像扩散模型

主要关键词