机构名称:

¥ 1.0

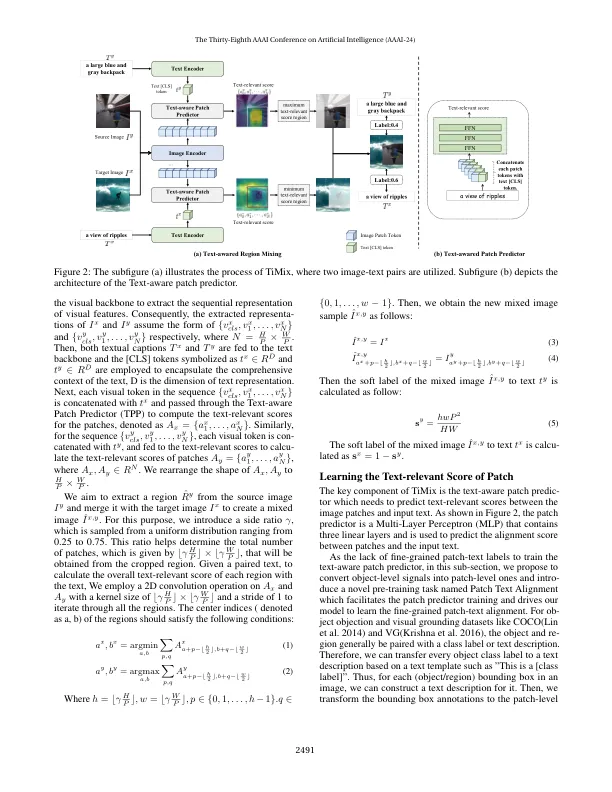

自我监管的多模式对比度学习(SMCL)明显地通过使视觉和语言方式结盟现代视觉预训练(VLP)模型。由于网络收获的文本图像对中的噪音,因此在计算成本和数据效率低下方面,SMCL的培训数据量扩大了相当大的obs。为了提高VLP的数据效率,我们提出了文本感知图像混合(TIMIX),该图像混合(TIMIX)将基于混合的数据增强技术集成到SMCL中,从而在没有显着增加计算开销的情况下进行了显着的性能改进。我们从共同信息(MI)的角度提供了TIMIX的理论分析,表明跨模式对比度学习的混合数据样本隐含地充当对比损失的常规器。实验结果表明,即使在针对现有方法的基准测试时,Timix在下游任务上也表现出可比的性能,即使减少了训练数据和较短的训练时间。这项工作在经验上和理论上证明了数据混合对于数据有效和计算可行的VLP的潜力,从而使更广泛的VLP模型在实际情况下受益。我们的代码可在https://github.com/chaoyajiang/timix/tree/main上使用。

timix:有效视觉的文本感知图像混合 - ...

主要关键词