机构名称:

¥ 1.0

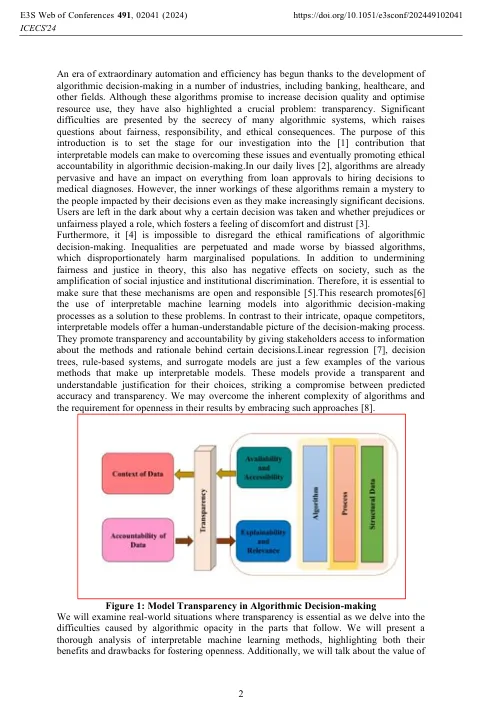

摘要:通过算法决策系统在各个领域的传播,人们对它们的不透明和潜在的道德后果的关注得到了提高。通过促进可解释的机器学习模型的使用,本研究解决了这些系统中开放性和道德责任的关键要求。可解释的模型提供了对决策的制定方式的透明且可理解的描述,而不是复杂的黑盒算法。用户和利益相关者需要这种开放性,以便理解,验证和负责这些算法的决定。此外,可解释性通过使检测和减少偏见更容易促进算法结果中的公平性。在本文中,我们概述了算法不透明度带来的困难,强调了在各种环境中解决这些困难的关键,包括涉及医疗保健,银行业,刑事司法等的困难。从线性模型到基于规则的系统再到替代模型,我们对可解释的机器学习技术进行了彻底的分析,突出了它们的好处和缺点。我们建议,将可解释的模型纳入算法的设计和使用可能会导致AI在社会中更负责任和道德应用,最终使人们和社区受益,同时降低与不透明决策过程相关的风险。

算法决策中的透明度

主要关键词