机构名称:

¥ 1.0

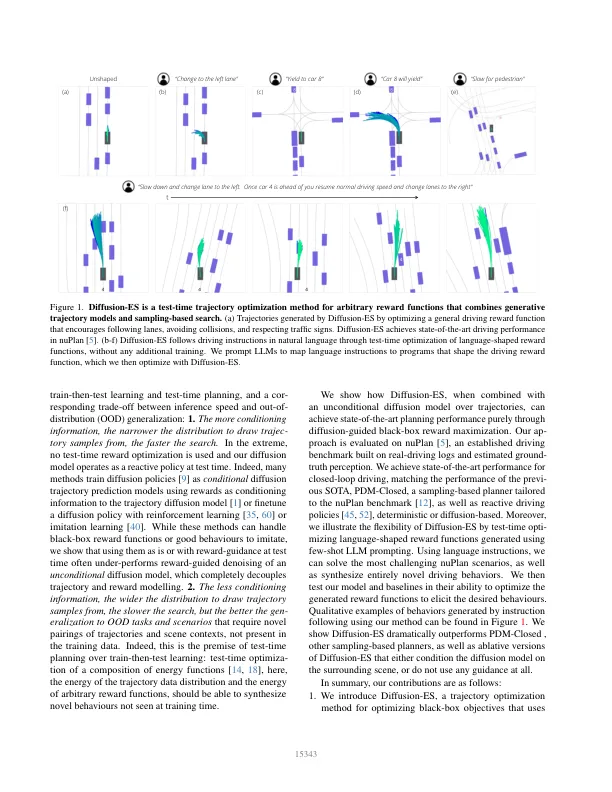

扩散模型在建模复合物和多模态轨迹分布方面表现出色,以进行决策和控制。最近提出了奖励级别指导的denoising,以生成轨迹,从而最大程度地提高了可差异的奖励函数,又是扩散模型捕获的数据分布下的可能性。奖励级别指导的denoisising需要适合清洁和噪声样本的可区分奖励功能,从而限制了其作为一般轨迹优化器的应用。在本文中,我们提出了扩散-ES,一种将无梯度优化与轨迹deNoising结合起来的方法,以优化黑框非差异性目标,同时留在数据管理中。扩散-ES样品在进化过程中的轨迹 - 从扩散模型中搜索,并使用黑框奖励函数得分。它使用截断的扩散过程突变高得分轨迹,该过程应用了少量的no弱和降解步骤,从而可以更有效地探索解决方案空间。我们表明,扩散-ES在Nuplan上实现了最先进的表现,Nuplan是一个已建立的闭环计划基准,用于自动驾驶。扩散-ES的表现优于现有的基于抽样的计划者,反应性确定性或基于扩散的策略以及奖励梯度指导。此外,我们表明,与先前的指导方法不同,我们的方法可以优化由少数弹药LLM提示产生的非差异性语言形状奖励功能。这使我们能够解决最困难的NUPLAN场景,这些方案超出了现有的传统优化方法和驾驶策略的能力。在以遵循指示的人类老师的指导下,我们的方法可以产生新颖的,高度复杂的行为,例如训练数据中不存在的积极的车道编织。1

扩散-ES:无梯度计划,扩散自主和指导引导

主要关键词