机构名称:

¥ 2.0

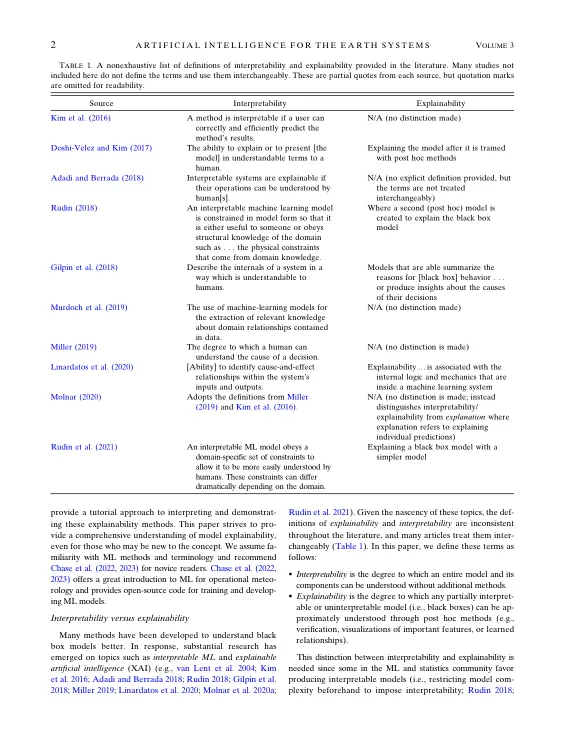

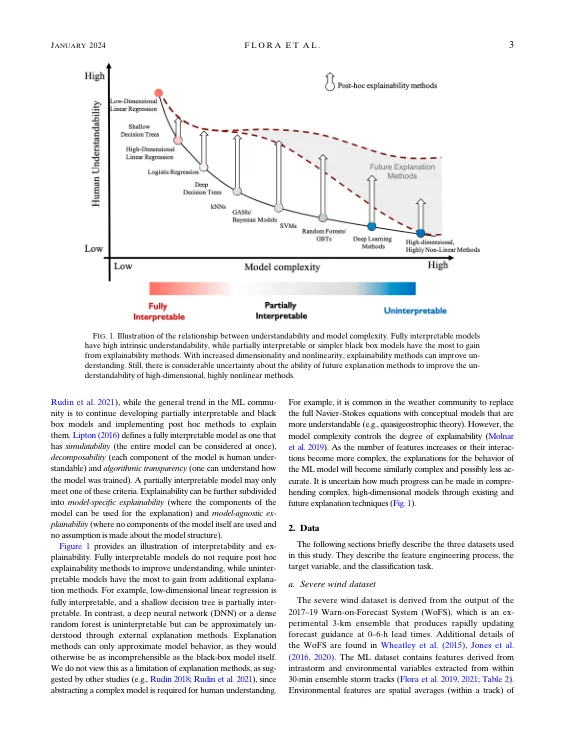

摘要:随着解释机器学习(ML)模型的兴趣越来越多,本文综合了许多与ML解释性相关的主题。我们将解释性与解释性,本地解释性以及功能重要性与功能相关性区分开。我们演示和可视化不同的解释方法,如何解释它们,并提供完整的Python软件包(Scikit-templain),以允许未来的研究人员和模型开发人员探索这些解释能力方法。解释性方法包括Shapley添加性解释(SHAP),Shapley添加剂全球解释(SAGE)和累积的局部效应(ALE)。我们的重点主要放在基于沙普利的技术上,这些技术是增强模型解释性的各种现有方法的统一框架。例如,制造一致的方法,例如可解释的模型 - 不合Snostic解释(lime)和树解释器,用于局部解释性,而鼠尾草则统一了对全球解释性的置换重要性的不同变化。我们提供了一个简短的教程,用于使用三个不同数据集解释ML模型:用于对流的模型数据集用于恶劣天气预测,一个用于子冷冻道路表面预测的幕后数据集,以及用于雷电预测的基于卫星的数据。此外,我们还展示了相关特征对模型的解释性的不利影响。最后,我们演示了评估特征组的模型图案而不是单个特征的概念。评估特征组可减轻特征相关性的影响,并可以对模型提供更全面的理解。本研究中使用的所有代码,模型和数据都可以自由使用,以加速大气和其他环境科学中的机器学习解释性。

大气科学的机器学习解释性教程

主要关键词