机构名称:

¥ 1.0

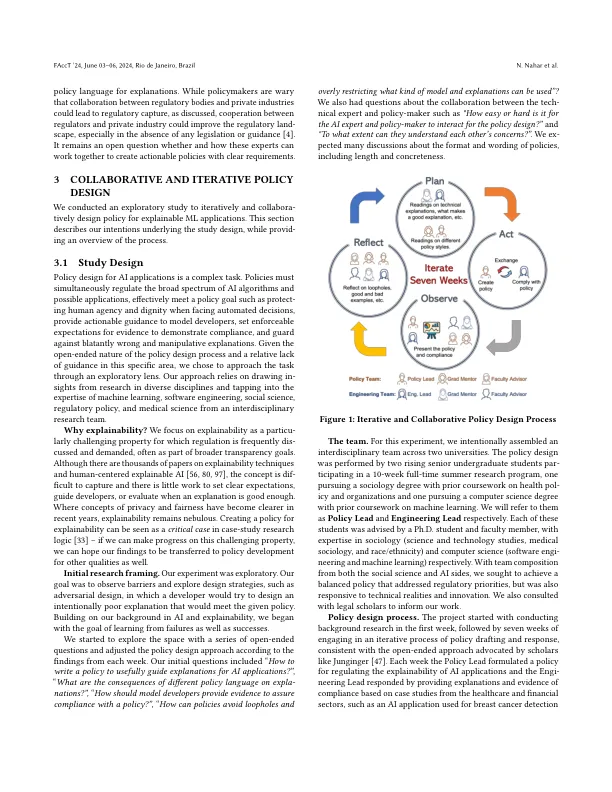

随着人工智能(AI)的兴起,对AI的关注,导致对安全,隐私,安全和公平性的危害正在加剧。尽管正在尝试制定法规的尝试正在进行,诸如《欧盟AI法》和2023年白宫行政命令之类的倡议持怀疑态度,但对此类法规的有效性充满了持怀疑态度。本文探讨了为AI应用程序解释性设计政策的跨学科范围,因为与欧盟一般数据保护法规相关的广泛讨论的“解释权”是模棱两可的。为了制定可解释性的实用指导,我们进行了一项实验研究,其中涉及在十个星期内具有AI和政策背景的研究人员之间的持续合作。目的是确定通过互际式的努力,我们是否可以就AI的解释性达成共识,该政策比目前的准则更清晰,更可行,更可行,更可执行。我们分享了九个观察结果,这些观察结果来自迭代政策设计过程,其中包括起草政策,试图遵守(或绕过它),并每周共同评估其有效性。主要观察结果包括:迭代和持续反馈对于随着时间的推移改善政策草案,在政策设计期间必要讨论合规性的证据,并且发现人类受试者的研究是一种重要的证据形式。这对政策制定者具有有希望的含义,表明可以实现对AI应用的实际和有效调节。我们以乐观情绪的注释,认为可以在适度的时间范围内实现有意义的政策,并且在政策设计方面的经验有限,这是我们团队中的学生研究人员所证明的。

调节机器学习应用中的解释性

主要关键词