机构名称:

¥ 1.0

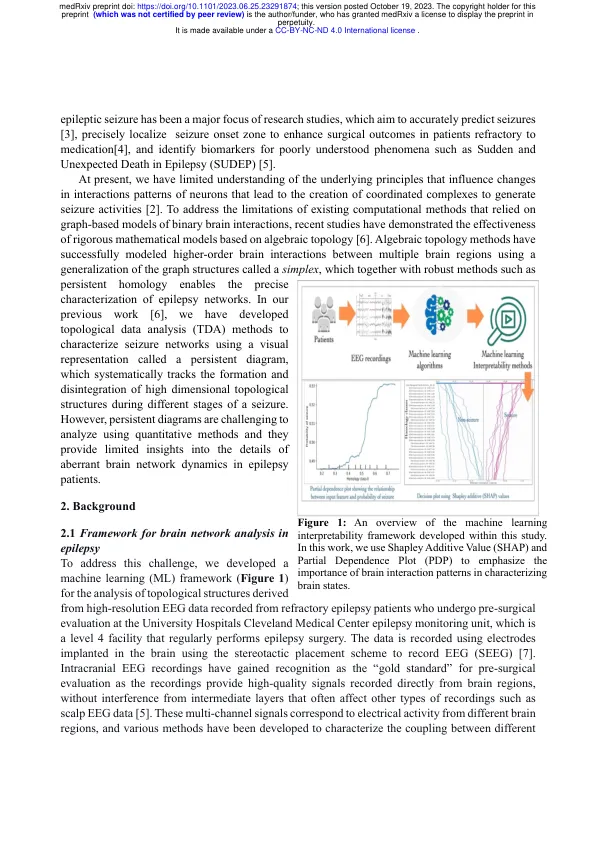

摘要 机器学习 (ML) 算法在广泛的生物医学应用中的快速应用凸显了信任问题以及对 ML 算法生成的结果缺乏理解。最近的研究集中于开发可解释的 ML 模型并制定透明度和道德使用指南,确保机器学习以负责任的方式融入医疗保健领域。在本研究中,我们证明了 ML 可解释性方法的有效性,可为癫痫症(一种影响全球超过 6000 万人的严重神经系统疾病)的大脑网络相互作用动态提供重要见解。使用来自 16 名患者的高分辨率颅内脑电图 (EEG) 记录,我们开发了高精度 ML 模型,将这些大脑活动记录分为癫痫发作或非癫痫发作类别,然后执行一项更复杂的任务,即描绘出癫痫发作发展到大脑不同部位的不同阶段,作为一项多类别分类任务。我们对高精度 ML 模型应用了三种不同类型的可解释性方法,以了解不同类别的大脑交互模式(包括多焦点交互)的相对贡献,这些模式在区分大脑的不同状态方面发挥着重要作用。本研究结果首次证明,事后可解释性方法使我们能够理解 ML 算法生成给定结果集的原因以及输入值的变化如何影响 ML 算法的准确性。特别是,我们在本研究中表明,可解释性方法可用于识别对癫痫发作事件有重大影响的大脑区域和交互模式。本研究结果强调了在异常脑网络研究和更广泛的生物医学研究领域中集成实施 ML 算法和可解释性方法的重要性。

机器学习可解释性方法来描述癫痫中的脑网络动态

主要关键词