机构名称:

¥ 1.0

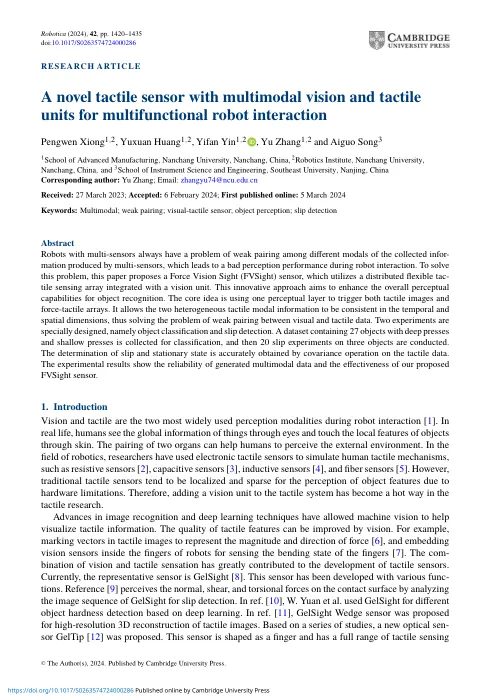

带有多传感器的抽象机器人总是在多传感器产生的收集的信息中的不同模态中遇到弱配对的问题,这导致机器人交互期间的感知性能不佳。为了解决此问题,本文提出了一个力视觉视觉(FVSight)传感器,该传感器利用了与视觉单元集成的分布式柔性tac-TaC-Tile传感阵列。这种创新的方法旨在增强对象识别的整体感知能力。核心想法是使用一个感知层触发触觉图像和力触觉阵列。它允许两个异质触觉模态信息在时间和空间维度上保持一致,从而解决了视觉和触觉数据之间弱配对的问题。两个实验是专门设计的,即对象分类和滑移检测。收集了一个包含27个具有深压和浅压力的对象的数据集进行分类,然后对三个对象进行了20个滑移实验。通过触觉数据,通过协方差操作准确地获得了滑动和固定状态的确定。实验结果显示了生成的多模式数据的可靠性以及我们提出的FVSight传感器的效果。

a-novel-tactile-sensor-with-multimodal-vision-and-...

主要关键词