机构名称:

¥ 3.0

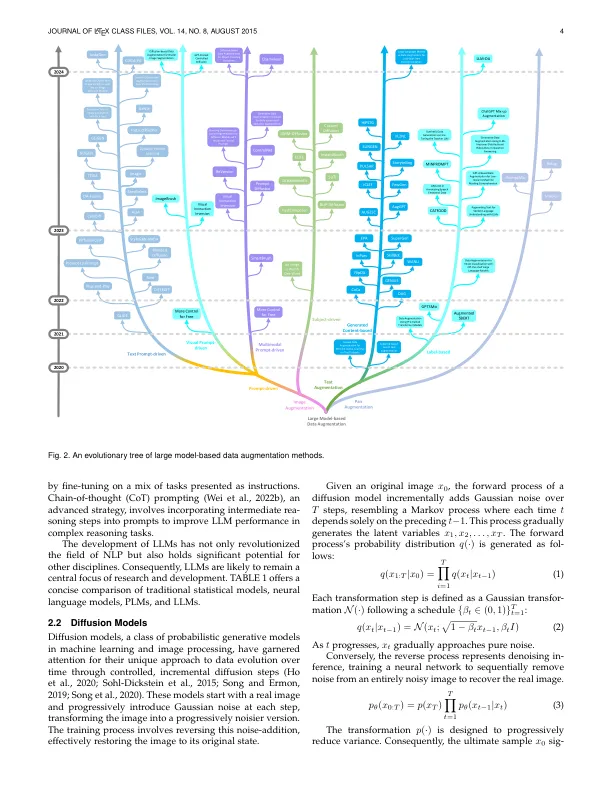

摘要 - 涵盖大型语言和扩散模型的规模模型在近似人类水平的智能方面表现出了非凡的希望,从而引起了学术和工业领域的重大兴趣。但是,对这些大型模型的培训需要大量的高质量数据,并且随着对这些模型的持续更新,现有的高质量数据储层很快可能会耗尽。这一挑战促进了针对数据增强方法的研究激增。利用大型模型,这些数据增强技术的表现优于传统方法。本文对大型模型驱动的数据增强方法进行了详尽的审查,采用了全面的观点。我们首先将相关研究的分类分为三个主要类别:图像增强,文本增强和配对的数据增强。之后,我们深入研究了与大型基于模型的数据增强有关的各种数据后处理技术。我们的讨论然后扩展,以涵盖自然语言处理,计算机视觉和音频信号处理中这些数据增强方法的一系列应用程序。我们开始评估不同情况下基于大型模型数据扩展的成功和局限性。在我们的审查结束时,我们重点介绍了潜在的挑战和途径,以实现数据增强领域的未来探索。我们的目标是为研究人员提供关键的见解,最终有助于生成足够多的数据来培训更复杂的大型模型。我们始终在以下位置维护相关的开源材料:https://github.com/mlgroup-jlu/llm-data-aug-survey。

大型模型时代的数据增强调查

主要关键词