机构名称:

¥ 1.0

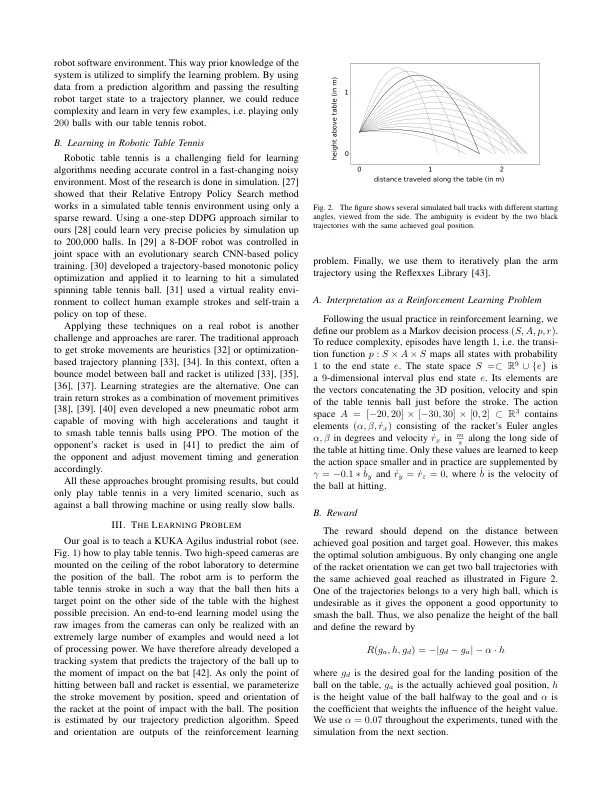

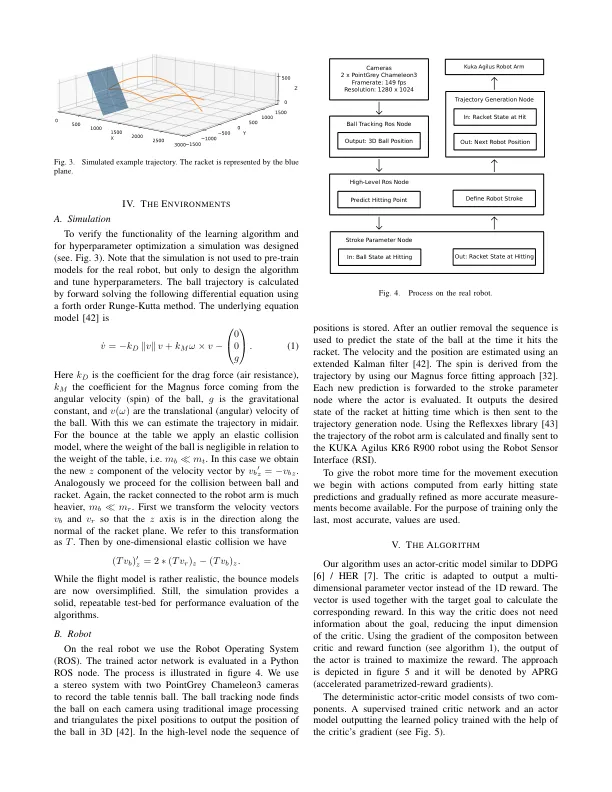

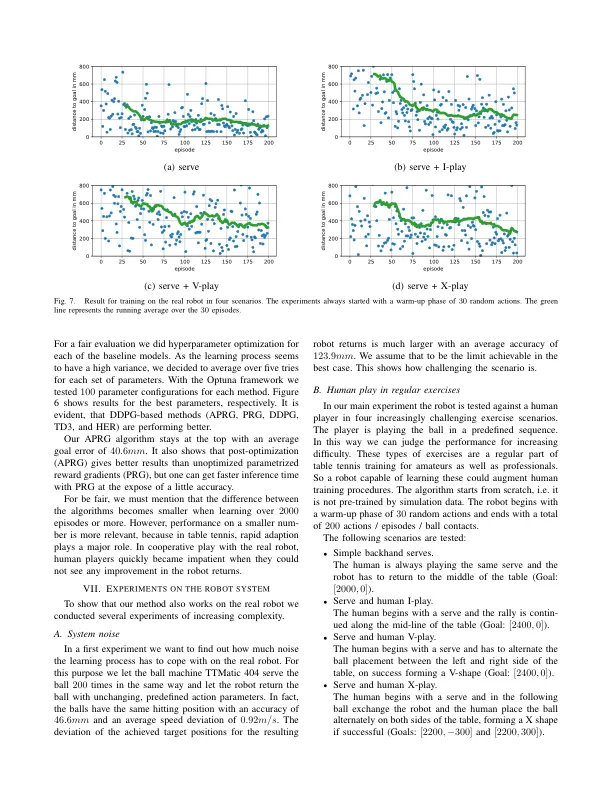

摘要 - 强化学习(RL)在各种计算机游戏和模拟中取得了一些令人印象深刻的成功。大多数这些成功都是基于代理可以从中学习的大量情节。在典型的机器人应用中,可行尝试的数量非常有限。在本文中,我们提出了一种应用于乒乓球机器人示例的样品效率RL算法。在乒乓球中,每个中风都有不同的位置,速度和旋转。因此,必须在高维连续状态空间上找到准确的回报。在几个试验中进行学习,该方法嵌入了我们的机器人系统中。通过这种方式,我们可以使用一个步骤的环境。状态空间在击球时间(位置,速度,旋转)时取决于球,而动作是击球时的球拍状态(方向,速度)。开发了一种基于参与者的确定性策略梯度算法,用于加速学习。我们的方法在模拟和在许多具有挑战性的场景中都具有竞争力。在200次培训发作中,无需预先培训即可获得准确的结果。呈现我们实验的视频可在https://youtu.be/uratdol6wpw上获得。

机器人表网球中的样品效率增强学习*