机构名称:

¥ 1.0

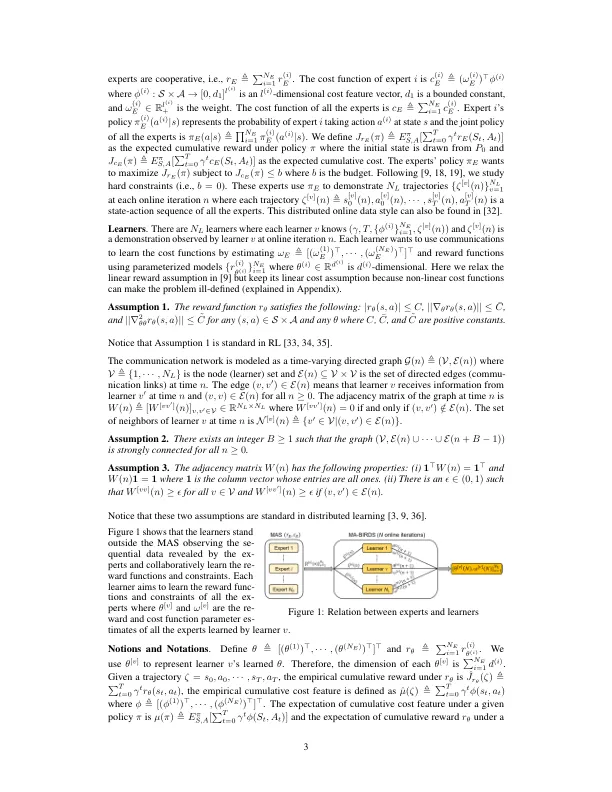

本文考虑了通过估算其奖励功能和约束来推断出多个相互作用专家行为的问题,在这些奖励功能和约束下,分布式所证明的轨迹被顺序向一组学习者揭示。我们将问题提出为分布式在线双层优化问题,其中外部级别的问题是估计奖励功能,而内部级别的问题是学习约束和相应的策略。我们提出了一种新颖的“来自分布式和流式演示的多代理行为推断”(MA鸟)算法,该算法使学习者可以通过间歇性通信在单个循环中解决外部级别和内部水平问题。我们正式保证分布式学习者就奖励功能,判断和政策达成共识,平均本地遗憾(在在线迭代中)以O(1 /n 1-η1+1 /n 1 +1 /n 1-η1-η2+1 /n)的速度下降,而累积约束违规会增加1 +1 +1 +1 +1 +1 +2 +nη (1/2,1)。

从分布式和流式演示中学习多代理行为